Dies ist die Linux-App mit dem Namen CTranslate2, deren neueste Version als CTranslate23.20.0.zip heruntergeladen werden kann. Es kann online beim kostenlosen Hosting-Anbieter OnWorks für Workstations ausgeführt werden.

Laden Sie diese App namens CTranslate2 mit OnWorks kostenlos herunter und führen Sie sie online aus.

Befolgen Sie diese Anweisungen, um diese App auszuführen:

- 1. Diese Anwendung auf Ihren PC heruntergeladen.

- 2. Geben Sie in unserem Dateimanager https://www.onworks.net/myfiles.php?username=XXXXX den gewünschten Benutzernamen ein.

- 3. Laden Sie diese Anwendung in einem solchen Dateimanager hoch.

- 4. Starten Sie den OnWorks Linux-Online- oder Windows-Online-Emulator oder den MACOS-Online-Emulator von dieser Website.

- 5. Rufen Sie vom gerade gestarteten OnWorks Linux-Betriebssystem aus unseren Dateimanager https://www.onworks.net/myfiles.php?username=XXXXX mit dem gewünschten Benutzernamen auf.

- 6. Laden Sie die Anwendung herunter, installieren Sie sie und führen Sie sie aus.

SCREENSHOTS

Ad

CTranslate2

BESCHREIBUNG

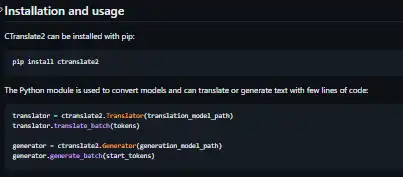

CTranslate2 ist eine C++- und Python-Bibliothek für effiziente Inferenz mit Transformer-Modellen. Das Projekt implementiert eine benutzerdefinierte Laufzeit, die viele Techniken zur Leistungsoptimierung wie Gewichtungsquantisierung, Ebenenfusion, Stapelneuordnung usw. anwendet, um die Speichernutzung von Transformer-Modellen auf CPU und GPU zu beschleunigen und zu reduzieren. Dank vieler erweiterter Optimierungen ist die Ausführung erheblich schneller und erfordert weniger Ressourcen als allgemeine Deep-Learning-Frameworks für unterstützte Modelle und Aufgaben: Layer-Fusion, Padding-Entfernung, Batch-Neuordnung, In-Place-Vorgänge, Caching-Mechanismus usw. Die Modellserialisierung und Berechnung unterstützt Gewichte mit reduzierter Genauigkeit: 16-Bit-Gleitkommazahlen (FP16), 16-Bit-Ganzzahlen (INT16) und 8-Bit-Ganzzahlen (INT8). Das Projekt unterstützt x86-64- und AArch64/ARM64-Prozessoren und integriert mehrere Backends, die für diese Plattformen optimiert sind: Intel MKL, oneDNN, OpenBLAS, Ruy und Apple Accelerate.

Eigenschaften

- Unterstützte Encoder-Decoder-Modelle

- GPT-2, GPT-J, GPT-NeoX, OPT, BLOOM werden unterstützt

- Automatische CPU-Erkennung und Code-Versand

- Schnelle und effiziente Ausführung auf CPU und GPU

- Quantisierung und reduzierte Präzision

- Unterstützung mehrerer CPU-Architekturen

- Dynamische Speichernutzung

- Parallele und asynchrone Ausführung

Programmiersprache

C + +

Kategorien

Dies ist eine Anwendung, die auch von https://sourceforge.net/projects/ctranslate2.mirror/ abgerufen werden kann. Es wurde in OnWorks gehostet, um es auf einfachste Weise online über eines unserer kostenlosen Betriebssysteme ausführen zu können.