Il s'agit de l'application Linux nommée Web Crawler Security Tool dont la dernière version peut être téléchargée sous le nom crawler_v1.0.1.tar.gz. Il peut être exécuté en ligne sur le fournisseur d'hébergement gratuit OnWorks pour les postes de travail.

Téléchargez et exécutez en ligne cette application nommée Web Crawler Security Tool avec OnWorks gratuitement.

Suivez ces instructions pour exécuter cette application :

- 1. Téléchargé cette application sur votre PC.

- 2. Entrez dans notre gestionnaire de fichiers https://www.onworks.net/myfiles.php?username=XXXXX avec le nom d'utilisateur que vous voulez.

- 3. Téléchargez cette application dans ce gestionnaire de fichiers.

- 4. Démarrez l'émulateur en ligne OnWorks Linux ou Windows en ligne ou l'émulateur en ligne MACOS à partir de ce site Web.

- 5. Depuis le système d'exploitation OnWorks Linux que vous venez de démarrer, accédez à notre gestionnaire de fichiers https://www.onworks.net/myfiles.php?username=XXXXX avec le nom d'utilisateur que vous souhaitez.

- 6. Téléchargez l'application, installez-la et exécutez-la.

CAPTURES D'ÉCRAN

Ad

Outil de sécurité du robot d'exploration Web

DESCRIPTION

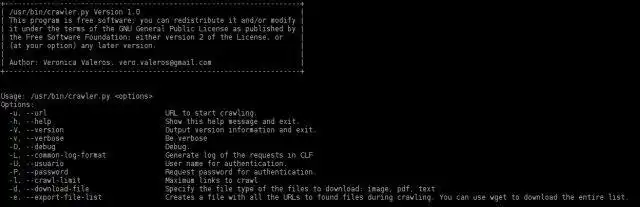

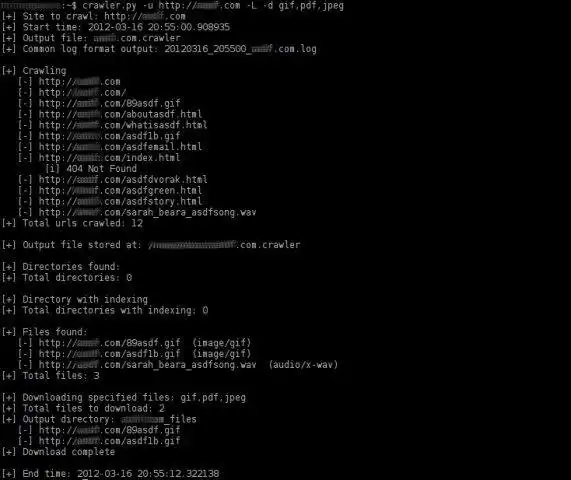

Dernière mise à jour le mar 26 mars 16:25 UTC 2012Web Crawler Security est un outil basé sur Python pour explorer automatiquement un site Web. Il s'agit d'un robot d'exploration Web destiné à aider dans les tâches de test d'intrusion. La tâche principale de cet outil est de rechercher et de répertorier tous les liens (pages et fichiers) d'un site Web.

Le crawler a été complètement réécrit en v1.0 apportant beaucoup d'améliorations : amélioration de la visualisation des données, option interactive pour télécharger des fichiers, augmentation de la vitesse de crawl, exporte la liste des fichiers trouvés dans un fichier séparé (utile pour explorer un site une fois, puis télécharger des fichiers et les analyser avec FOCA), générer un journal de sortie au format Common Log Format (CLF), gérer l'authentification de base et plus encore !

La plupart des anciennes fonctionnalités ont été réimplémentées et la plus intéressante est la capacité du robot d'exploration à rechercher l'indexation des répertoires.

Caractéristiques

- Explorez les sites Web http et https (même les sites Web n'utilisant pas de ports communs). Explorez les sites Web http et https (même les sites Web n'utilisant pas de ports communs). Explorez les sites Web http et https (même les sites Web n'utilisant pas de ports communs).

- (nouveau !) Il permet de déterminer la profondeur du crawling (-C option)

- (nouveau !) Génère un résumé à la fin du crawl avec des statistiques sur les résultats du crawl

- (nouveau !) Implémentation de la méthode HEAD pour analyser les types de fichiers avant l'exploration. Cette fonction améliore considérablement la vitesse du crawler.

- Utilise des expressions régulières pour rechercher les liens 'href', 'src' et 'content'.

- Identifie les liens relatifs.

- Identifie les fichiers non-html et les affiche.

- Ne pas explorer les fichiers non-html.

- Identifie l'indexation des répertoires.

- Explorer les répertoires avec indexation (pas encore implémenté dans la v1.0)

- Utilise CTRL-C pour arrêter les étapes actuelles du robot et continuer à travailler. Des trucs très utiles...

- Identifie tous les types de fichiers en lisant le champ d'en-tête de type de contenu de la réponse.

- Exporte (option -e) dans un fichier séparé une liste de toutes les URL de fichiers trouvées lors de l'exploration.

- Sélectionnez le type de fichiers à télécharger (option -d). Ex. : png,pdf,jpeg,gif ou png,jpeg.

- Sélectionnez de manière interactive le type de fichiers à télécharger (option -i).

- Enregistrez les fichiers téléchargés dans un répertoire. Il ne crée le répertoire de sortie que s'il y a au moins un fichier à télécharger.

- Génère un journal de sortie au format CLF (Common Log Format) de toutes les requêtes effectuées lors du crawl.

- (bêta) Connectez-vous avec une authentification de base. Les commentaires sont les bienvenus !

- Essaie de détecter si le site Web utilise un CMS (comme wordpress, joomla, etc.) (pas encore implémenté dans la v1.0)

- Il recherche les fichiers '.bk' ou '.bak' des pages php, asp, aspx, jps. (pas encore implémenté dans la v1.0)

- Il identifie et calcule le nombre de pages Web uniques explorées. (pas encore implémenté dans la v1.0)

- Il identifie et calcule le nombre de pages Web uniques explorées qui contiennent des paramètres dans l'URL. (pas encore implémenté dans la v1.0)

- Cela fonctionne sous Windows, mais n'a pas encore enregistré les résultats

Audience

Technologies de l'information

Interface utilisateur

Console/Terminal

Langage de programmation

Python

Il s'agit d'une application qui peut également être récupérée à partir de https://sourceforge.net/projects/webcrawler-py/. Il a été hébergé dans OnWorks afin d'être exécuté en ligne de la manière la plus simple à partir de l'un de nos systèmes d'exploitation gratuits.