Il s'agit de l'application Windows nommée LocalAI dont la dernière version peut être téléchargée sous le nom v1.30.0.zip. Il peut être exécuté en ligne chez le fournisseur d'hébergement gratuit OnWorks pour les postes de travail.

Téléchargez et exécutez gratuitement en ligne cette application nommée LocalAI avec OnWorks.

Suivez ces instructions pour exécuter cette application :

- 1. Téléchargé cette application sur votre PC.

- 2. Entrez dans notre gestionnaire de fichiers https://www.onworks.net/myfiles.php?username=XXXXX avec le nom d'utilisateur que vous voulez.

- 3. Téléchargez cette application dans ce gestionnaire de fichiers.

- 4. Démarrez n'importe quel émulateur en ligne OS OnWorks à partir de ce site Web, mais un meilleur émulateur en ligne Windows.

- 5. Depuis le système d'exploitation OnWorks Windows que vous venez de démarrer, accédez à notre gestionnaire de fichiers https://www.onworks.net/myfiles.php?username=XXXXX avec le nom d'utilisateur que vous souhaitez.

- 6. Téléchargez l'application et installez-la.

- 7. Téléchargez Wine depuis les dépôts de logiciels de vos distributions Linux. Une fois installé, vous pouvez ensuite double-cliquer sur l'application pour les exécuter avec Wine. Vous pouvez également essayer PlayOnLinux, une interface sophistiquée sur Wine qui vous aidera à installer des programmes et des jeux Windows populaires.

Wine est un moyen d'exécuter un logiciel Windows sur Linux, mais sans Windows requis. Wine est une couche de compatibilité Windows open source qui peut exécuter des programmes Windows directement sur n'importe quel bureau Linux. Essentiellement, Wine essaie de ré-implémenter suffisamment de Windows à partir de zéro pour qu'il puisse exécuter toutes ces applications Windows sans avoir réellement besoin de Windows.

CAPTURES D'ÉCRAN

Ad

IA locale

DESCRIPTION

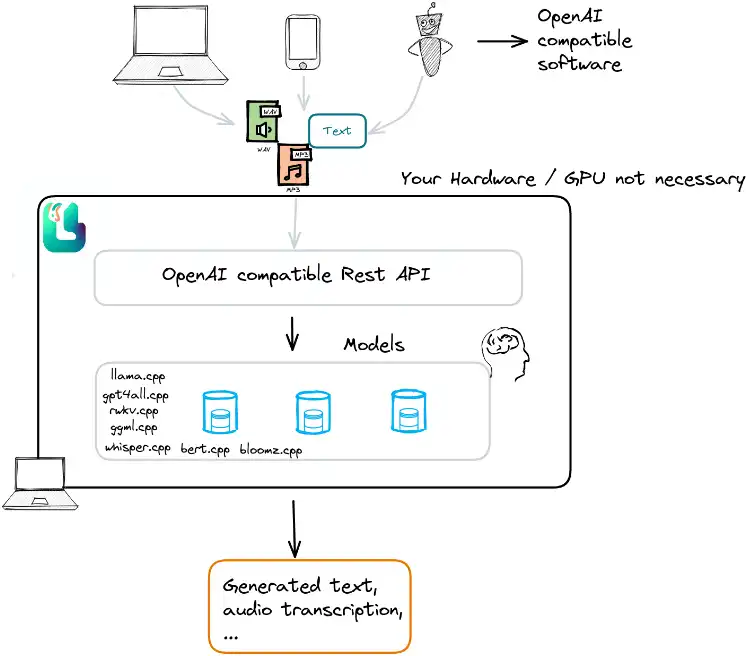

API locale auto-hébergée, pilotée par la communauté et compatible avec OpenAI. Remplacement immédiat d'OpenAI exécutant des LLM sur du matériel grand public. Alternative gratuite à l'Open Source et à l'OpenAI. Aucun GPU n'est requis. Exécute les modèles compatibles ggml, GPTQ, onnx, TF : lama, gpt4all, rwkv, murmure, vicuna, koala, gpt4all-j, cerebras, falcon, dolly, starcoder et bien d'autres. LocalAI est une API REST de remplacement compatible avec les spécifications de l'API OpenAI pour l'inférence locale. Il vous permet d'exécuter des LLM (et pas seulement) localement ou sur site avec du matériel grand public, prenant en charge plusieurs familles de modèles compatibles avec le format ggml. Ne nécessite pas de GPU.

Caractéristiques

- API REST alternative locale et OpenAI

- AUCUN GPU requis

- Prend en charge plusieurs modèles

- Une fois chargé pour la première fois, il conserve les modèles chargés en mémoire pour une inférence plus rapide

- Ne coûte pas cher, mais utilise les liaisons C++ pour une inférence plus rapide et de meilleures performances

- Vous possédez vos données

Langage de programmation

Go

Catégories

Il s'agit d'une application qui peut également être récupérée sur https://sourceforge.net/projects/localai.mirror/. Il a été hébergé dans OnWorks afin de pouvoir être exécuté en ligne de la manière la plus simple possible à partir de l'un de nos systèmes d'exploitation gratuits.