Ini adalah aplikasi Windows bernama TensorFlow Serving yang rilis terbarunya dapat diunduh sebagai 2.13.1.zip. Ini dapat dijalankan secara online di penyedia hosting gratis OnWorks untuk workstation.

Unduh dan jalankan secara online aplikasi bernama TensorFlow Serving with OnWorks ini secara gratis.

Ikuti petunjuk ini untuk menjalankan aplikasi ini:

- 1. Download aplikasi ini di PC Anda.

- 2. Masuk ke file manager kami https://www.onworks.net/myfiles.php?username=XXXXX dengan username yang anda inginkan.

- 3. Upload aplikasi ini di filemanager tersebut.

- 4. Mulai emulator online OS OnWorks apa pun dari situs web ini, tetapi emulator online Windows yang lebih baik.

- 5. Dari OS Windows OnWorks yang baru saja Anda mulai, buka file manager kami https://www.onworks.net/myfiles.php?username=XXXXX dengan nama pengguna yang Anda inginkan.

- 6. Unduh aplikasi dan instal.

- 7. Unduh Wine dari repositori perangkat lunak distribusi Linux Anda. Setelah terinstal, Anda kemudian dapat mengklik dua kali aplikasi untuk menjalankannya dengan Wine. Anda juga dapat mencoba PlayOnLinux, antarmuka mewah di atas Wine yang akan membantu Anda menginstal program dan game Windows populer.

Wine adalah cara untuk menjalankan perangkat lunak Windows di Linux, tetapi tidak memerlukan Windows. Wine adalah lapisan kompatibilitas Windows sumber terbuka yang dapat menjalankan program Windows secara langsung di desktop Linux apa pun. Pada dasarnya, Wine mencoba untuk mengimplementasikan kembali Windows dari awal sehingga dapat menjalankan semua aplikasi Windows tersebut tanpa benar-benar membutuhkan Windows.

Tangkapan layar

Ad

Melayani TensorFlow

DESKRIPSI

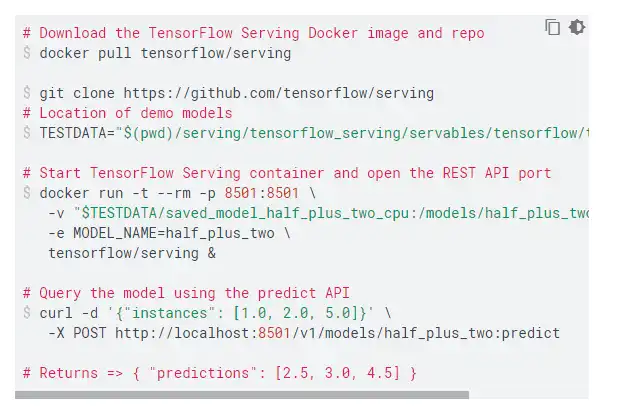

TensorFlow Serving adalah sistem penayangan yang fleksibel dan berperforma tinggi untuk model pembelajaran mesin, yang dirancang untuk lingkungan produksi. Ini berkaitan dengan aspek inferensi pembelajaran mesin, mengambil model setelah pelatihan dan mengelola masa hidup mereka, memberikan klien akses berversi melalui tabel pencarian referensi yang dihitung dengan kinerja tinggi. TensorFlow Serving menyediakan integrasi langsung dengan model TensorFlow, tetapi dapat dengan mudah diperluas untuk melayani jenis model dan data lainnya. Cara termudah dan paling mudah dalam menggunakan TensorFlow Serving adalah dengan gambar Docker. Kami sangat merekomendasikan rute ini kecuali Anda memiliki kebutuhan khusus yang tidak ditangani dengan menjalankannya dalam wadah. Untuk menyajikan model Tensorflow, cukup ekspor SavedModel dari program Tensorflow Anda. SavedModel adalah format serialisasi hermetis yang netral bahasa, dapat dipulihkan, yang memungkinkan sistem dan alat tingkat lebih tinggi untuk memproduksi, menggunakan, dan mengubah model TensorFlow.

Fitur

- Dapat melayani beberapa model, atau beberapa versi dari model yang sama secara bersamaan

- Mengekspos titik akhir inferensi gRPC serta HTTP

- Memungkinkan penyebaran versi model baru tanpa mengubah kode klien apa pun

- Mendukung versi baru canarying dan model eksperimental pengujian A/B

- Menambahkan latensi minimal ke waktu inferensi karena implementasi overhead yang efisien dan rendah

- Menampilkan penjadwal yang mengelompokkan permintaan inferensi individu ke dalam batch untuk eksekusi bersama pada GPU, dengan kontrol latensi yang dapat dikonfigurasi

Bahasa Pemrograman

C + +

Kategori

Ini adalah aplikasi yang juga dapat diambil dari https://sourceforge.net/projects/tensorflow-serving.mirror/. Ini telah di-host di OnWorks untuk dijalankan secara online dengan cara termudah dari salah satu Sistem Operasi gratis kami.