Questa è l'app Linux denominata Web Crawler Security Tool la cui ultima versione può essere scaricata come crawler_v1.0.1.tar.gz. Può essere eseguito online nel provider di hosting gratuito OnWorks per workstation.

Scarica ed esegui online questa app denominata Web Crawler Security Tool con OnWorks gratuitamente.

Segui queste istruzioni per eseguire questa app:

- 1. Scaricata questa applicazione sul tuo PC.

- 2. Entra nel nostro file manager https://www.onworks.net/myfiles.php?username=XXXXX con il nome utente che desideri.

- 3. Carica questa applicazione in tale file manager.

- 4. Avviare l'emulatore online OnWorks Linux o Windows online o l'emulatore online MACOS da questo sito Web.

- 5. Dal sistema operativo OnWorks Linux che hai appena avviato, vai al nostro file manager https://www.onworks.net/myfiles.php?username=XXXXX con il nome utente che desideri.

- 6. Scarica l'applicazione, installala ed eseguila.

IMMAGINI

Ad

Strumento di sicurezza del crawler Web

DESCRIZIONE

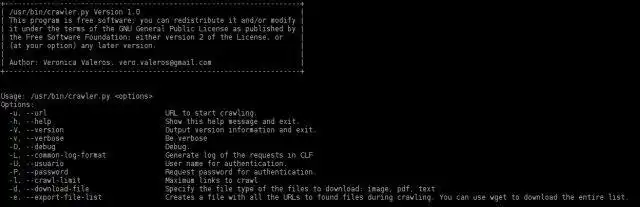

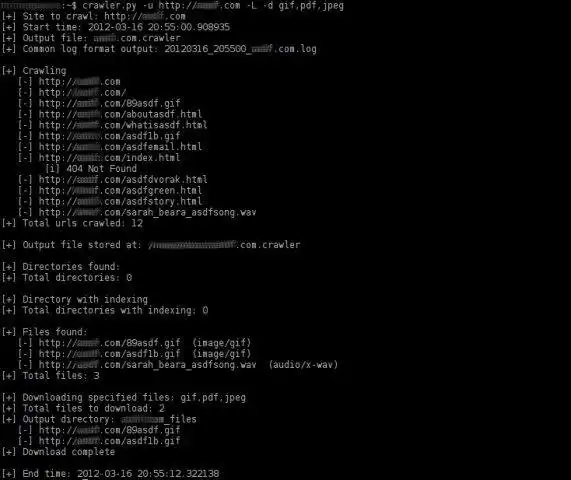

Ultimo aggiornamento il mar 26 mar 16:25 UTC 2012Il Web Crawler Security è uno strumento basato su Python per eseguire la scansione automatica di un sito web. È un web crawler orientato ad aiutare nelle attività di test di penetrazione. Il compito principale di questo strumento è cercare ed elencare tutti i collegamenti (pagine e file) in un sito web.

Il crawler è stato completamente riscritto nella v1.0 apportando molti miglioramenti: migliorata la visualizzazione dei dati, opzione interattiva per scaricare i file, maggiore velocità nella scansione, esporta l'elenco dei file trovati in un file separato (utile per eseguire la scansione di un sito una volta, quindi scaricare file e analizzarli con FOCA), generare un registro di output in Common Log Format (CLF), gestire l'autenticazione di base e altro ancora!

Molte delle vecchie funzionalità sono state reimplementate e la più interessante è la capacità del crawler di cercare l'indicizzazione delle directory.

Caratteristiche

- Scansiona i siti Web http e https (anche i siti Web che non utilizzano porte comuni). Scansiona i siti Web http e https (anche i siti Web che non utilizzano porte comuni). Scansiona i siti Web http e https (anche i siti Web che non utilizzano porte comuni).

- (novità!) Permette di determinare la profondità del gattonare (-C opzione)

- (novità!) Genera un riepilogo alla fine della scansione con le statistiche sui risultati della scansione

- (nuovo!) Metodo HEAD implementato per analizzare i tipi di file prima della scansione. Questa funzione migliora notevolmente la velocità del crawler.

- Utilizza le espressioni regolari per trovare i collegamenti 'href', 'src' e 'content'.

- Identifica i collegamenti relativi.

- Identifica i file non html e li mostra.

- Non eseguire la scansione di file non html.

- Identifica l'indicizzazione della directory.

- Scansione directory con indicizzazione (non ancora implementata nella v1.0)

- Utilizza CTRL-C per interrompere le fasi correnti del crawler e continuare a lavorare. Roba molto utile...

- Identifica tutti i tipi di file leggendo il campo dell'intestazione del tipo di contenuto della risposta.

- Esporta (opzione -e) in un file separato un elenco di tutti i file URL trovati durante la scansione.

- Seleziona il tipo di file da scaricare (opzione -d). Es.: png,pdf,jpeg,gif o png,jpeg.

- Seleziona in modo interattivo quale tipo di file scaricare (opzione -i).

- Salva i file scaricati in una directory. Crea la directory di output solo se c'è almeno un file da scaricare.

- Genera un log di output in CLF (Common Log Format) di tutte le richieste effettuate durante la scansione.

- (beta) Accedi con autenticazione di base. Il feedback è il benvenuto!

- Cerca di rilevare se il sito Web utilizza un CMS (come wordpress, joomla, ecc.) (non ancora implementato nella v1.0)

- Cerca i file '.bk' o '.bak' delle pagine php, asp, aspx, jps. (non ancora implementato nella v1.0)

- Identifica e calcola il numero di pagine Web univoche sottoposte a scansione. (non ancora implementato nella v1.0)

- Identifica e calcola il numero di pagine Web univoche scansionate che contengono parametri nell'URL. (non ancora implementato nella v1.0)

- Funziona in Windows, ma non ha ancora salvato i risultati

Pubblico

Information Technology

Interfaccia utente

Console/Terminale

Linguaggio di programmazione

Python

Questa è un'applicazione che può anche essere scaricata da https://sourceforge.net/projects/webcrawler-py/. È stato ospitato in OnWorks per essere eseguito online nel modo più semplice da uno dei nostri sistemi operativi gratuiti.