これは PML という名前の Linux アプリで、その最新リリースは v2.3.0.zip としてダウンロードできます。 これは、ワークステーション用の無料のホスティング プロバイダーである OnWorks でオンラインで実行できます。

PML with OnWorks という名前のこのアプリをオンラインで無料でダウンロードして実行します。

このアプリを実行するには、次の手順に従ってください。

-1。このアプリケーションをPCにダウンロードしました。

--2。ファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXに必要なユーザー名を入力します。

-3。このアプリケーションをそのようなファイルマネージャにアップロードします。

-4。このWebサイトからOnWorksLinuxオンラインまたはWindowsオンラインエミュレーターまたはMACOSオンラインエミュレーターを起動します。

-5。起動したばかりのOnWorksLinux OSから、必要なユーザー名でファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXにアクセスします。

-6。アプリケーションをダウンロードし、インストールして実行します。

スクリーンショットは

Ad

PML

DESCRIPTION

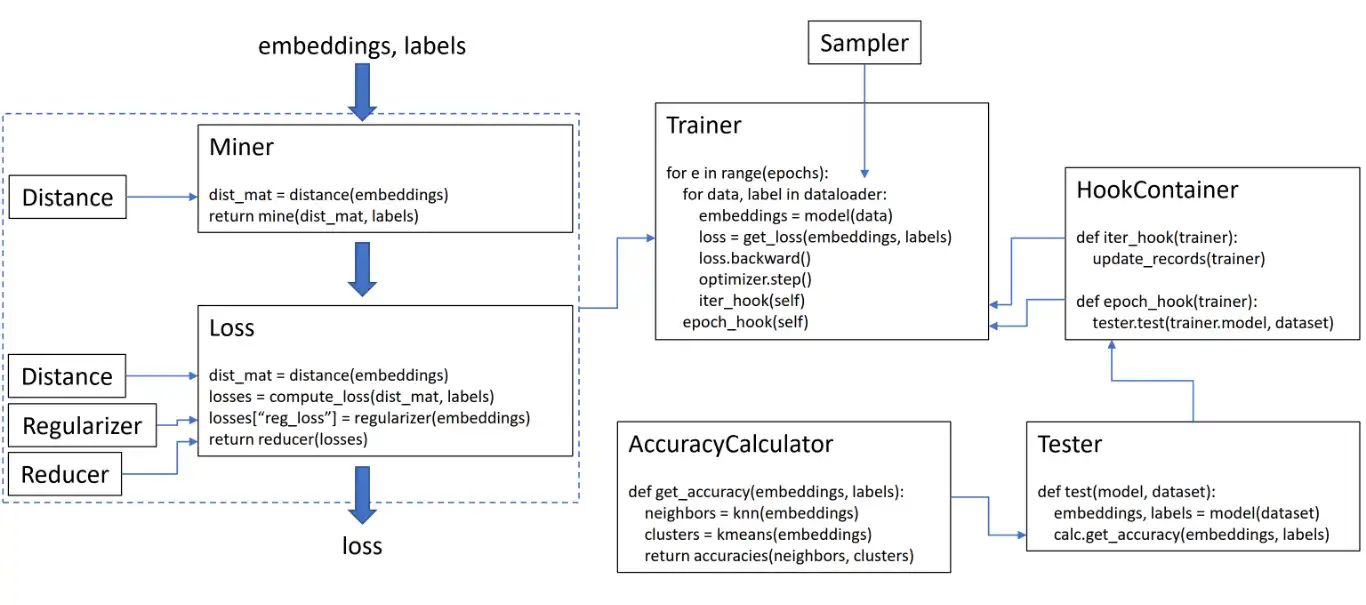

このライブラリには 9 つのモジュールが含まれており、それぞれを既存のコードベース内で個別に使用することも、組み合わせて完全なトレーニング/テスト ワークフローにすることもできます。 トレーニング ループで損失を計算するには、モデルによって計算された埋め込みと対応するラベルを渡します。 埋め込みにはサイズ (N、embedding_size) が必要であり、ラベルにはサイズ (N) が必要です。ここで、N はバッチ サイズです。 TripletMarginLoss は、渡されたラベルに基づいて、バッチ内で可能なすべてのトリプレットを計算します。 アンカー ポジティブ ペアは、同じラベルを共有する埋め込みによって形成され、アンカー ネガティブ ペアは、異なるラベルを持つ埋め込みによって形成されます。 損失関数は、距離、リデューサー、正則化を使用してカスタマイズできます。 下の図では、マイナーがバッチ内でハードペアのインデックスを見つけています。 これらは、距離オブジェクトによって計算された距離行列にインデックスを付けるために使用されます。 この図では、損失関数はペアベースであるため、ペアごとの損失を計算します。

特徴

- 損失関数のカスタマイズ

- 教師なし/自己教師あり学習に損失関数を使用する

- 必要な PyTorch バージョン torch >= 1.6

- 開発は dev ブランチで行われます

- コードは黒と isort を使用してフォーマットされています

- テストデータ型とテストデバイスを環境変数として指定できます

プログラミング言語

Python

カテゴリー

これは https://sourceforge.net/projects/pml.mirror/ からも取得できるアプリケーションです。 これは、OnWorks でホストされており、無料のオペレーティング システムの XNUMX つからオンラインで簡単に実行できます。