これは、Web Crawler Security Tool という名前の Linux アプリで、最新リリースは、crawler_v1.0.1.tar.gz としてダウンロードできます。 ワークステーション用の無料ホスティング プロバイダー OnWorks でオンラインで実行できます。

Web Crawler Security Tool with OnWorks という名前のこのアプリをオンラインで無料でダウンロードして実行します。

このアプリを実行するには、次の手順に従ってください。

-1。このアプリケーションをPCにダウンロードしました。

--2。ファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXに必要なユーザー名を入力します。

-3。このアプリケーションをそのようなファイルマネージャにアップロードします。

-4。このWebサイトからOnWorksLinuxオンラインまたはWindowsオンラインエミュレーターまたはMACOSオンラインエミュレーターを起動します。

-5。起動したばかりのOnWorksLinux OSから、必要なユーザー名でファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXにアクセスします。

-6。アプリケーションをダウンロードし、インストールして実行します。

スクリーンショットは

Ad

Web クローラー セキュリティ ツール

DESCRIPTION

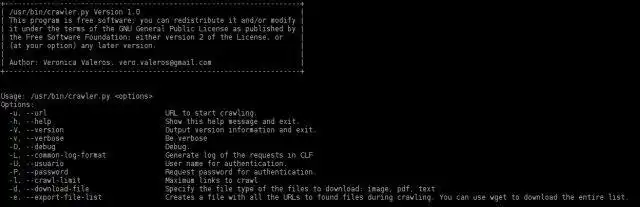

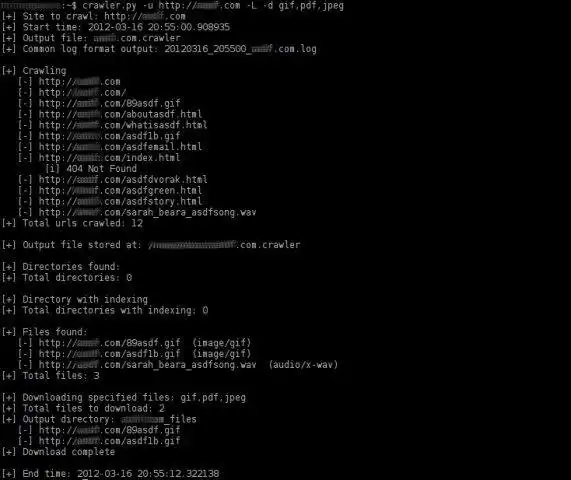

最終更新日 26 年 16 月 25 日火曜日 2012:XNUMX UTCWeb クローラー セキュリティは、Web サイトを自動的にクロールするための Python ベースのツールです。 これは、侵入テスト タスクを支援することを目的とした Web クローラーです。 このツールの主なタスクは、Web サイト内のすべてのリンク (ページとファイル) を検索して一覧表示することです。

クローラーは v1.0 で完全に書き直され、多くの改善が行われました。データの視覚化の改善、ファイルをダウンロードするための対話型オプション、クロールの速度の向上、見つかったファイルのリストを別のファイルにエクスポートします (サイトを一度クロールし、その後クロールする場合に便利です)ファイルをダウンロードして FOCA で分析)、Common Log Format (CLF) で出力ログを生成、基本認証などを管理します。

古い機能の多くは再実装されており、最も興味深い機能は、ディレクトリのインデックス付けを検索するクローラーの機能です。

特徴

- http および https Web サイト (共通ポートを使用していない Web サイトも含む) をクロールします。 http および https Web サイト (共通ポートを使用していない Web サイトも含む) をクロールします。 http および https Web サイト (共通ポートを使用していない Web サイトも含む) をクロールします。

- (新機能!) クロールの深さを決定することができます (-C オプション)

- (新機能!) クロールの最後に、クロール結果に関する統計を含む概要を生成します。

- (新規!) クロール前にファイル タイプを分析するための HEAD メソッドが実装されました。 この機能により、クローラーの速度が大幅に向上します。

- 正規表現を使用して、「href」、「src」、および「content」リンクを検索します。

- 相対リンクを識別します。

- 非 HTML ファイルを識別して表示します。

- 非 HTML ファイルはクロールしません。

- ディレクトリのインデックス作成を識別します。

- インデックスを使用してディレクトリをクロールします (v1.0 ではまだ実装されていません)

- CTRL-C を使用して現在のクローラー ステージを停止し、作業を続行します。 とても便利なもの...

- 応答の content-type ヘッダー フィールドを読み取ることで、すべての種類のファイルを識別します。

- クロール中に見つかったすべてのファイル URL のリストを別のファイルにエクスポートします (-e オプション)。

- ダウンロードするファイルの種類を選択します (-d オプション)。 例: png、pdf、jpeg、gif または png、jpeg。

- ダウンロードするファイルの種類を対話形式で選択します (-i オプション)。

- ダウンロードしたファイルをディレクトリに保存します。 ダウンロードするファイルが少なくとも XNUMX つある場合にのみ、出力ディレクトリが作成されます。

- クロール中に実行されたすべてのリクエストの出力ログを CLF (共通ログ形式) で生成します。

- (ベータ版) Basic認証でログインします。 フィードバックは大歓迎です!

- Web サイトが CMS (wordpress、joomla など) を使用しているかどうかの検出を試みます (v1.0 ではまだ実装されていません)

- php、asp、aspx、jps ページの「.bk」または「.bak」ファイルを検索します。 (v1.0ではまだ実装されていません)

- クロールされた一意の Web ページの数を識別して計算します。 (v1.0ではまだ実装されていません)

- URL にパラメータを含む、クロールされた一意の Web ページの数を識別して計算します。 (v1.0ではまだ実装されていません)

- Windows では動作しますが、結果はまだ保存されていません

Audience

情報技術

ユーザーインターフェース

コンソール/ターミナル

プログラミング言語

Python

これは、https://sourceforge.net/projects/webcrawler-py/ から取得できるアプリケーションです。 無料のオペレーティング システムの XNUMX つから最も簡単な方法でオンラインで実行できるように、OnWorks でホストされています。