これは TensorRT という名前の Windows アプリで、最新リリースは TensorRTOSSv9.1.0sourcecode.zip としてダウンロードできます。 ワークステーション用の無料ホスティング プロバイダー OnWorks でオンラインで実行できます。

TensorRTという名前のこのアプリをOnWorksで無料でダウンロードしてオンラインで実行します。

このアプリを実行するには、次の手順に従ってください。

-1。このアプリケーションをPCにダウンロードしました。

--2。ファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXに必要なユーザー名を入力します。

-3。このアプリケーションをそのようなファイルマネージャにアップロードします。

-4。このWebサイトからOSOnWorksオンラインエミュレーターを起動しますが、Windowsオンラインエミュレーターの方が優れています。

-5。起動したばかりのOnWorksWindows OSから、必要なユーザー名でファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXにアクセスします。

-6。アプリケーションをダウンロードしてインストールします。

-7.LinuxディストリビューションソフトウェアリポジトリからWineをダウンロードします。 インストールしたら、アプリをダブルクリックして、Wineで実行できます。 また、人気のあるWindowsプログラムやゲームのインストールに役立つWine上の豪華なインターフェイスであるPlayOnLinuxを試すこともできます。

WineはLinux上でWindowsソフトウェアを実行する方法ですが、Windowsは必要ありません。 Wineは、任意のLinuxデスクトップでWindowsプログラムを直接実行できるオープンソースのWindows互換性レイヤーです。 基本的に、Wineは、実際にWindowsを必要とせずに、これらすべてのWindowsアプリケーションを実行できるように、十分な数のWindowsを最初から再実装しようとしています。

スクリーンショットは

Ad

TensorRT

DESCRIPTION

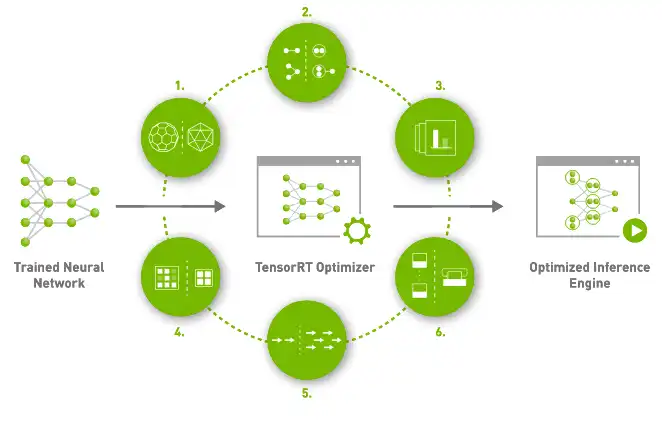

NVIDIA®TensorRT™は、高性能の深層学習推論のためのSDKです。 ディープラーニング推論オプティマイザーとランタイムが含まれており、ディープラーニング推論アプリケーションに低レイテンシーと高スループットを提供します。 TensorRTベースのアプリケーションは、推論中にCPUのみのプラットフォームよりも最大40倍高速に実行されます。 TensorRTを使用すると、すべての主要なフレームワークでトレーニングされたニューラルネットワークモデルを最適化し、低精度を高精度で調整し、ハイパースケールデータセンター、組み込み、または自動車製品プラットフォームに展開できます。 TensorRTは、NVIDIAの並列プログラミングモデルであるCUDA®に基づいて構築されており、人工知能、自律型マシン、高性能コンピューティング、およびグラフィックス向けに、CUDA-X™のライブラリ、開発ツール、およびテクノロジを活用して推論を最適化できます。 新しいNVIDIAAmpereアーキテクチャGPUを使用すると、TensorRTはスパーステンソルコアも活用して、パフォーマンスをさらに向上させます。

特徴

- TensorRTは、量子化対応トレーニングとトレーニング後の量子化を使用してINT8を提供します

- ビデオストリーミング、音声認識、推奨などの深層学習推論アプリケーションの実稼働展開。

- 精度の推論が低下すると、アプリケーションの待機時間が大幅に短縮されます

- TensorRTを使用すると、開発者は、推論展開のパフォーマンスチューニングではなく、新しいAIを利用したアプリケーションの作成に集中できます。

- 精度を維持しながらモデルを量子化することにより、FP16またはINT8でスループットを最大化します

- カーネル内のノードを融合することにより、GPUメモリと帯域幅の使用を最適化します

プログラミング言語

C + +

カテゴリー

これは、https://sourceforge.net/projects/tensorrt.mirror/からも取得できるアプリケーションです。 無料のオペレーティングシステムのXNUMXつから最も簡単な方法でオンラインで実行するために、OnWorksでホストされています。