이것은 최신 릴리스를 DeepSpeedMIIv0.0.8.zip으로 다운로드할 수 있는 DeepSpeed MII라는 Windows 앱입니다. 워크스테이션용 무료 호스팅 제공업체인 OnWorks에서 온라인으로 실행할 수 있습니다.

OnWorks가 포함된 DeepSpeed MII라는 앱을 무료로 온라인으로 다운로드하여 실행해 보세요.

이 앱을 실행하려면 다음 지침을 따르세요.

- 1. 이 애플리케이션을 PC에 다운로드했습니다.

- 2. 파일 관리자 https://www.onworks.net/myfiles.php?username=XXXXX에 원하는 사용자 이름을 입력합니다.

- 3. 이러한 파일 관리자에서 이 응용 프로그램을 업로드합니다.

- 4. 이 웹사이트에서 모든 OS OnWorks 온라인 에뮬레이터를 시작하지만 더 나은 Windows 온라인 에뮬레이터를 시작합니다.

- 5. 방금 시작한 OnWorks Windows OS에서 원하는 사용자 이름으로 파일 관리자 https://www.onworks.net/myfiles.php?username=XXXXX로 이동합니다.

- 6. 애플리케이션을 다운로드하여 설치합니다.

- 7. Linux 배포 소프트웨어 저장소에서 Wine을 다운로드합니다. 설치가 완료되면 앱을 두 번 클릭하여 Wine과 함께 실행할 수 있습니다. 인기 있는 Windows 프로그램 및 게임을 설치하는 데 도움이 되는 Wine을 통한 멋진 인터페이스인 PlayOnLinux를 사용해 볼 수도 있습니다.

Wine은 Linux에서 Windows 소프트웨어를 실행하는 방법이지만 Windows가 필요하지 않습니다. Wine은 모든 Linux 데스크탑에서 직접 Windows 프로그램을 실행할 수 있는 오픈 소스 Windows 호환성 계층입니다. 본질적으로 Wine은 Windows가 필요하지 않고 모든 Windows 응용 프로그램을 실행할 수 있도록 Windows를 처음부터 충분히 다시 구현하려고 합니다.

스크린 샷

Ad

딥스피드 MII

기술

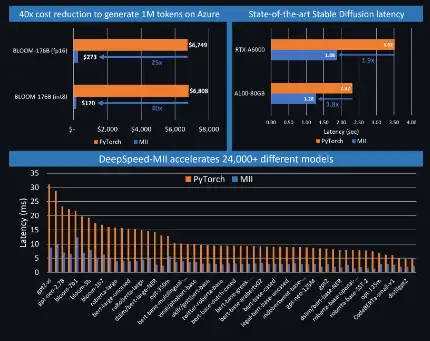

MII는 DeepSpeed를 기반으로 짧은 지연 시간과 높은 처리량의 추론을 가능하게 합니다. 딥 러닝(DL) 오픈 소스 커뮤니티는 지난 몇 달 동안 엄청난 성장을 보였습니다. Bloom 176B와 같은 믿을 수 없을 정도로 강력한 텍스트 생성 모델이나 Stable Diffusion과 같은 이미지 생성 모델은 이제 Hugging Face와 같은 플랫폼을 통해 소수 또는 단일 GPU에 액세스할 수 있는 누구나 사용할 수 있습니다. 오픈 소스는 AI 기능에 대한 액세스를 민주화했지만, 해당 애플리케이션은 여전히 추론 지연 시간과 비용이라는 두 가지 중요한 요소로 인해 제한됩니다. DeepSpeed-MII는 DeepSpeed의 새로운 오픈 소스 Python 라이브러리로, 실행 가능하고 쉽게 액세스할 수 있는 강력한 모델에 대한 낮은 대기 시간, 저렴한 비용의 추론을 목표로 합니다. MII는 널리 사용되는 수천 개의 DL 모델의 고도로 최적화된 구현에 대한 액세스를 제공합니다. MII 지원 모델은 원래 구현에 비해 대기 시간과 비용이 크게 낮아졌습니다.

기능

- MII는 널리 사용되는 수천 개의 DL 모델의 고도로 최적화된 구현에 대한 액세스를 제공합니다.

- MII 지원 모델은 원래 구현에 비해 대기 시간과 비용이 크게 낮아졌습니다.

- MII는 변환기용 딥퓨전과 같은 DeepSpeed-Inference의 광범위한 최적화 세트를 활용합니다.

- 최첨단 성능

- MII는 단 몇 줄의 코드만으로 AML을 통해 온-프레미스와 Azure 모두에서 이러한 모델의 저렴한 배포를 지원합니다.

- 다중 GPU 추론을 위한 자동화된 텐서 슬라이싱, ZeroQuant를 통한 즉석 양자화

프로그래밍 언어

Python

카테고리

이는 https://sourceforge.net/projects/deepspeed-mii.mirror/에서도 가져올 수 있는 애플리케이션입니다. 무료 운영 시스템 중 하나에서 가장 쉬운 방법으로 온라인으로 실행하기 위해 OnWorks에서 호스팅되었습니다.