이것은 NGCcontainer2.38.0.zip에 해당하는 Release23.09으로 최신 릴리스를 다운로드할 수 있는 Triton Inference Server라는 Windows 앱입니다. 워크스테이션용 무료 호스팅 제공업체 OnWorks에서 온라인으로 실행할 수 있습니다.

OnWorks와 함께 Triton Inference Server라는 이 앱을 무료로 다운로드하여 온라인으로 실행하십시오.

이 앱을 실행하려면 다음 지침을 따르세요.

- 1. 이 애플리케이션을 PC에 다운로드했습니다.

- 2. 파일 관리자 https://www.onworks.net/myfiles.php?username=XXXXX에 원하는 사용자 이름을 입력합니다.

- 3. 이러한 파일 관리자에서 이 응용 프로그램을 업로드합니다.

- 4. 이 웹사이트에서 모든 OS OnWorks 온라인 에뮬레이터를 시작하지만 더 나은 Windows 온라인 에뮬레이터를 시작합니다.

- 5. 방금 시작한 OnWorks Windows OS에서 원하는 사용자 이름으로 파일 관리자 https://www.onworks.net/myfiles.php?username=XXXXX로 이동합니다.

- 6. 애플리케이션을 다운로드하여 설치합니다.

- 7. Linux 배포 소프트웨어 저장소에서 Wine을 다운로드합니다. 설치가 완료되면 앱을 두 번 클릭하여 Wine과 함께 실행할 수 있습니다. 인기 있는 Windows 프로그램 및 게임을 설치하는 데 도움이 되는 Wine을 통한 멋진 인터페이스인 PlayOnLinux를 사용해 볼 수도 있습니다.

Wine은 Linux에서 Windows 소프트웨어를 실행하는 방법이지만 Windows가 필요하지 않습니다. Wine은 모든 Linux 데스크탑에서 직접 Windows 프로그램을 실행할 수 있는 오픈 소스 Windows 호환성 계층입니다. 본질적으로 Wine은 Windows가 필요하지 않고 모든 Windows 응용 프로그램을 실행할 수 있도록 Windows를 처음부터 충분히 다시 구현하려고 합니다.

스크린 샷

Ad

트리톤 추론 서버

기술

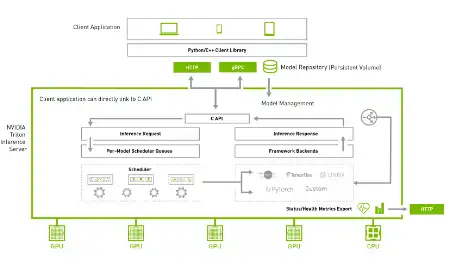

Triton Inference Server는 AI 추론을 간소화하는 오픈 소스 추론 제공 소프트웨어입니다. Triton을 사용하면 팀이 TensorRT, TensorFlow, PyTorch, ONNX, OpenVINO, Python, RAPIDS FIL 등을 비롯한 여러 딥 러닝 및 기계 학습 프레임워크의 모든 AI 모델을 배포할 수 있습니다. Triton은 NVIDIA GPU, x86 및 ARM CPU 또는 AWS Inferentia에서 클라우드, 데이터 센터, 에지 및 임베디드 장치 전반에 걸쳐 추론을 지원합니다. Triton은 실시간, 일괄 처리, 앙상블 및 오디오/비디오 스트리밍을 포함한 다양한 쿼리 유형에 최적화된 성능을 제공합니다. 사용자 정의 백엔드 및 사전/사후 처리 작업을 추가할 수 있는 백엔드 API를 제공합니다. Ensembling 또는 BLS(Business Logic Scripting)를 사용하여 파이프라인을 모델링합니다. 커뮤니티에서 개발한 KServe 프로토콜을 기반으로 하는 HTTP/REST 및 GRPC 추론 프로토콜. AC API 및 Java API를 통해 Triton은 에지 및 기타 프로세스 내 사용 사례를 위해 애플리케이션에 직접 연결할 수 있습니다.

기능

- 여러 딥 러닝 프레임워크 지원

- 여러 기계 학습 프레임워크 지원

- 동시 모델 실행

- 동적 일괄 처리

- 상태 저장 모델에 대한 시퀀스 일괄 처리 및 암시적 상태 관리

- 사용자 정의 백엔드 및 사전/사후 처리 작업을 추가할 수 있는 백엔드 API 제공

프로그래밍 언어

Python

카테고리

https://sourceforge.net/projects/triton-inference-server.mirror/에서도 가져올 수 있는 애플리케이션입니다. 무료 운영 체제 중 하나에서 가장 쉬운 방법으로 온라인으로 실행하기 위해 OnWorks에서 호스팅되었습니다.