Este é o aplicativo Linux chamado TensorRT Backend For ONNX cuja versão mais recente pode ser baixada como ONNX-TensorRT8.6EARelease.zip. Ele pode ser executado online no provedor de hospedagem gratuito OnWorks para estações de trabalho.

Baixe e execute online este aplicativo chamado TensorRT Backend For ONNX with OnWorks gratuitamente.

Siga estas instruções para executar este aplicativo:

- 1. Baixe este aplicativo em seu PC.

- 2. Entre em nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que você deseja.

- 3. Carregue este aplicativo em tal gerenciador de arquivos.

- 4. Inicie o emulador OnWorks Linux online ou Windows online ou emulador MACOS online a partir deste site.

- 5. No sistema operacional OnWorks Linux que você acabou de iniciar, acesse nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que deseja.

- 6. Baixe o aplicativo, instale-o e execute-o.

SCREENSHOTS

Ad

Backend TensorRT para ONNX

DESCRIÇÃO

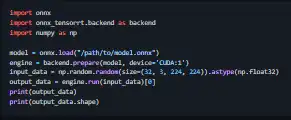

Analisa modelos ONNX para execução com TensorRT. O desenvolvimento na ramificação principal é para a versão mais recente do TensorRT 8.4.1.5 com dimensões completas e suporte a formas dinâmicas. Para versões anteriores do TensorRT, consulte suas respectivas ramificações. A construção de objetos INetwork no modo de dimensões completas com suporte a formas dinâmicas requer a chamada da API C++ e Python. Os operadores ONNX atualmente suportados são encontrados na matriz de suporte do operador. Para criar dentro do docker, recomendamos usar e configurar os contêineres docker conforme instruído no principal (repositório TensorRT). Observe que este projeto tem uma dependência de CUDA. Por padrão, a compilação procurará em /usr/local/cuda a instalação do kit de ferramentas CUDA. Se o caminho CUDA for diferente, substitua o caminho padrão. Os modelos ONNX podem ser convertidos em mecanismos TensorRT serializados usando o executável onnx2trt.

Recursos

- Os modelos ONNX podem ser convertidos em texto legível por humanos

- Os modelos ONNX podem ser convertidos em motores TensorRT serializados

- Os modelos ONNX podem ser otimizados pelas bibliotecas de otimização do ONNX

- Módulos Python

- TensorRT 8.4.1.5 suporta ONNX versão 1.8.0

- O back-end TensorRT para ONNX pode ser usado em Python

Linguagem de Programação

C + +

Categorias

Este é um aplicativo que também pode ser obtido em https://sourceforge.net/projects/tensorrt-backend-onnx.mirror/. Foi alojado em OnWorks para poder ser executado online da forma mais simples desde um dos nossos Sistemas Operativos gratuitos.