Este é o aplicativo do Windows denominado DeepSpeed MII, cuja versão mais recente pode ser baixada como DeepSpeedMIIv0.0.8.zip. Ele pode ser executado online no provedor de hospedagem gratuito OnWorks para estações de trabalho.

Baixe e execute online este aplicativo chamado DeepSpeed MII com OnWorks gratuitamente.

Siga estas instruções para executar este aplicativo:

- 1. Baixe este aplicativo em seu PC.

- 2. Entre em nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que você deseja.

- 3. Carregue este aplicativo em tal gerenciador de arquivos.

- 4. Inicie qualquer emulador on-line OS OnWorks a partir deste site, mas um emulador on-line melhor do Windows.

- 5. No sistema operacional OnWorks Windows que você acabou de iniciar, acesse nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que deseja.

- 6. Baixe o aplicativo e instale-o.

- 7. Baixe o Wine de seus repositórios de software de distribuição Linux. Depois de instalado, você pode clicar duas vezes no aplicativo para executá-lo com o Wine. Você também pode experimentar o PlayOnLinux, uma interface sofisticada do Wine que o ajudará a instalar programas e jogos populares do Windows.

Wine é uma forma de executar software Windows no Linux, mas sem a necessidade de Windows. Wine é uma camada de compatibilidade do Windows de código aberto que pode executar programas do Windows diretamente em qualquer desktop Linux. Essencialmente, o Wine está tentando reimplementar o suficiente do Windows do zero para que possa executar todos os aplicativos do Windows sem realmente precisar do Windows.

SCREENSHOTS

Ad

DeepSpeed MII

DESCRIÇÃO

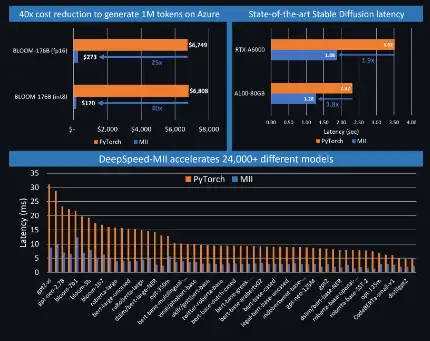

O MII possibilita inferência de baixa latência e alto rendimento, com tecnologia DeepSpeed. A comunidade de código aberto Deep Learning (DL) teve um enorme crescimento nos últimos meses. Modelos de geração de texto incrivelmente poderosos, como o Bloom 176B, ou modelos de geração de imagens, como o Stable Diffusion, estão agora disponíveis para qualquer pessoa com acesso a um punhado ou até mesmo a uma única GPU por meio de plataformas como o Hugging Face. Embora o código aberto tenha democratizado o acesso às capacidades de IA, a sua aplicação ainda é restringida por dois factores críticos: latência de inferência e custo. DeepSpeed-MII é uma nova biblioteca python de código aberto da DeepSpeed, destinada a tornar a inferência de modelos poderosos de baixa latência e baixo custo não apenas viável, mas também facilmente acessível. MII oferece acesso à implementação altamente otimizada de milhares de modelos DL amplamente utilizados. Os modelos suportados por MII alcançam latência e custo significativamente mais baixos em comparação com sua implementação original.

Recursos

- MII oferece acesso à implementação altamente otimizada de milhares de modelos DL amplamente utilizados

- Os modelos suportados por MII alcançam latência e custo significativamente mais baixos em comparação com sua implementação original

- MII aproveita um extenso conjunto de otimizações do DeepSpeed-Inference, como deepfusion para transformadores

- Desempenho de última geração

- O MII oferece suporte à implantação de baixo custo desses modelos tanto no local quanto no Azure via AML com apenas algumas linhas de códigos

- Fatiamento de tensor automatizado para inferência multi-GPU, quantização instantânea com ZeroQuant

Linguagem de Programação

Python

Categorias

Este é um aplicativo que também pode ser obtido em https://sourceforge.net/projects/deepspeed-mii.mirror/. Foi hospedado em OnWorks para poder ser executado online da maneira mais fácil a partir de um de nossos Sistemas Operativos gratuitos.