Este é o aplicativo do Windows chamado Triton Inference Server, cuja versão mais recente pode ser baixada como Release2.38.0correspondente ao NGCcontainer23.09.zip. Ele pode ser executado online no provedor de hospedagem gratuito OnWorks para estações de trabalho.

Baixe e execute online este aplicativo chamado Triton Inference Server com OnWorks gratuitamente.

Siga estas instruções para executar este aplicativo:

- 1. Baixe este aplicativo em seu PC.

- 2. Entre em nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que você deseja.

- 3. Carregue este aplicativo em tal gerenciador de arquivos.

- 4. Inicie qualquer emulador on-line OS OnWorks a partir deste site, mas um emulador on-line melhor do Windows.

- 5. No sistema operacional OnWorks Windows que você acabou de iniciar, acesse nosso gerenciador de arquivos https://www.onworks.net/myfiles.php?username=XXXXX com o nome de usuário que deseja.

- 6. Baixe o aplicativo e instale-o.

- 7. Baixe o Wine de seus repositórios de software de distribuição Linux. Depois de instalado, você pode clicar duas vezes no aplicativo para executá-lo com o Wine. Você também pode experimentar o PlayOnLinux, uma interface sofisticada do Wine que o ajudará a instalar programas e jogos populares do Windows.

Wine é uma forma de executar software Windows no Linux, mas sem a necessidade de Windows. Wine é uma camada de compatibilidade do Windows de código aberto que pode executar programas do Windows diretamente em qualquer desktop Linux. Essencialmente, o Wine está tentando reimplementar o suficiente do Windows do zero para que possa executar todos os aplicativos do Windows sem realmente precisar do Windows.

SCREENSHOTS

Ad

Servidor de Inferência Triton

DESCRIÇÃO

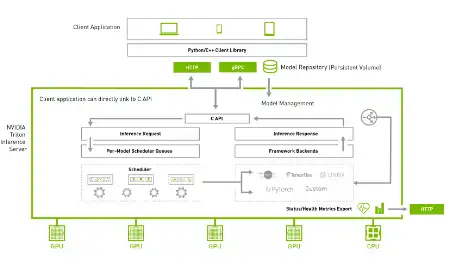

O Triton Inference Server é um software de serviço de inferência de código aberto que simplifica a inferência de IA. A Triton permite que as equipes implantem qualquer modelo de IA de várias estruturas de aprendizado profundo e aprendizado de máquina, incluindo TensorRT, TensorFlow, PyTorch, ONNX, OpenVINO, Python, RAPIDS FIL e muito mais. O Triton oferece suporte à inferência em nuvem, data center, borda e dispositivos incorporados em GPUs NVIDIA, CPU x86 e ARM ou AWS Inferentia. O Triton oferece desempenho otimizado para muitos tipos de consulta, incluindo em tempo real, em lote, conjuntos e streaming de áudio/vídeo. Fornece API de back-end que permite adicionar back-ends personalizados e operações de pré/pós-processamento. Modele pipelines usando Ensembling ou Business Logic Scripting (BLS). Protocolos de inferência HTTP/REST e GRPC baseados no protocolo KServe desenvolvido pela comunidade. A API AC e a API Java permitem que o Triton vincule diretamente ao seu aplicativo para casos de uso de borda e outros em processo.

Recursos

- Suporta várias estruturas de aprendizado profundo

- Suporta várias estruturas de aprendizado de máquina

- Execução simultânea do modelo

- Lote dinâmico

- Sequenciamento em lote e gerenciamento de estado implícito para modelos com estado

- Fornece API de back-end que permite adicionar back-ends personalizados e operações de pré/pós-processamento

Linguagem de Programação

Python

Categorias

Este é um aplicativo que também pode ser obtido em https://sourceforge.net/projects/triton-inference-server.mirror/. Ele foi hospedado no OnWorks para ser executado on-line da maneira mais fácil a partir de um de nossos sistemas operacionais gratuitos.