Aceasta este aplicația Windows numită Triton Inference Server a cărei ultimă versiune poate fi descărcată ca Release2.38.0correspondingtoNGCcontainer23.09.zip. Poate fi rulat online în furnizorul de găzduire gratuit OnWorks pentru stații de lucru.

Descărcați și rulați online această aplicație numită Triton Inference Server cu OnWorks gratuit.

Urmați aceste instrucțiuni pentru a rula această aplicație:

- 1. Ați descărcat această aplicație pe computer.

- 2. Introduceți în managerul nostru de fișiere https://www.onworks.net/myfiles.php?username=XXXXX cu numele de utilizator pe care îl doriți.

- 3. Încărcați această aplicație într-un astfel de manager de fișiere.

- 4. Porniți orice emulator online OS OnWorks de pe acest site, dar mai bun emulator online Windows.

- 5. Din sistemul de operare Windows OnWorks pe care tocmai l-ați pornit, accesați managerul nostru de fișiere https://www.onworks.net/myfiles.php?username=XXXXX cu numele de utilizator dorit.

- 6. Descărcați aplicația și instalați-o.

- 7. Descărcați Wine din depozitele de software ale distribuțiilor Linux. Odată instalat, puteți apoi să faceți dublu clic pe aplicație pentru a le rula cu Wine. De asemenea, puteți încerca PlayOnLinux, o interfață elegantă peste Wine, care vă va ajuta să instalați programe și jocuri populare Windows.

Wine este o modalitate de a rula software-ul Windows pe Linux, dar fără a fi necesar Windows. Wine este un strat de compatibilitate Windows open-source care poate rula programe Windows direct pe orice desktop Linux. În esență, Wine încearcă să reimplementeze suficient Windows de la zero, astfel încât să poată rula toate acele aplicații Windows fără a avea nevoie efectiv de Windows.

SCREENSHOTS

Ad

Triton Inference Server

DESCRIERE

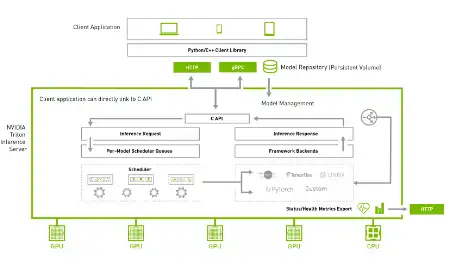

Triton Inference Server este un software de servire a inferențelor open-source care simplifică inferența AI. Triton permite echipelor să implementeze orice model AI din mai multe cadre de învățare profundă și învățare automată, inclusiv TensorRT, TensorFlow, PyTorch, ONNX, OpenVINO, Python, RAPIDS FIL și multe altele. Triton acceptă inferența în cloud, centre de date, edge și dispozitive încorporate pe GPU-uri NVIDIA, CPU x86 și ARM sau AWS Inferentia. Triton oferă performanțe optimizate pentru multe tipuri de interogări, inclusiv în timp real, în loturi, ansambluri și streaming audio/video. Oferă API Backend care permite adăugarea de backend personalizate și operațiuni de pre/post-procesare. Modelați conducte folosind Ensembling sau Business Logic Scripting (BLS). Protocoale de inferență HTTP/REST și GRPC bazate pe protocolul KServe dezvoltat de comunitate. API-ul AC și API-ul Java îi permit lui Triton să se conecteze direct la aplicația dvs. pentru cazuri de utilizare edge și alte cazuri în proces.

DESCRIERE

- Suportă mai multe cadre de învățare profundă

- Suportă mai multe cadre de învățare automată

- Execuție concomitentă a modelului

- Loturi dinamice

- Loturi de secvențe și management implicit al stării pentru modele cu stare

- Oferă API Backend care permite adăugarea de backend personalizate și operațiuni de pre/post procesare

Limbaj de programare

Piton

Categorii

Aceasta este o aplicație care poate fi preluată și de la https://sourceforge.net/projects/triton-inference-server.mirror/. Acesta a fost găzduit în OnWorks pentru a fi rulat online în cel mai simplu mod de la unul dintre sistemele noastre operative gratuite.