Это приложение для Windows под названием llama2-webui, последнюю версию которого можно загрузить как v0.1.14Release.zip. Его можно запустить онлайн на бесплатном хостинг-провайдере OnWorks для рабочих станций.

Загрузите и запустите онлайн это приложение под названием llama2-webui с помощью OnWorks бесплатно.

Следуйте этим инструкциям, чтобы запустить это приложение:

- 1. Загрузил это приложение на свой компьютер.

- 2. Введите в нашем файловом менеджере https://www.onworks.net/myfiles.php?username=XXXXX с желаемым именем пользователя.

- 3. Загрузите это приложение в такой файловый менеджер.

- 4. Запустите любой онлайн-эмулятор OS OnWorks с этого сайта, но лучше онлайн-эмулятор Windows.

- 5. В только что запущенной ОС Windows OnWorks перейдите в наш файловый менеджер https://www.onworks.net/myfiles.php?username=XXXXX с желаемым именем пользователя.

- 6. Скачайте приложение и установите его.

- 7. Загрузите Wine из репозиториев программного обеспечения вашего дистрибутива Linux. После установки вы можете дважды щелкнуть приложение, чтобы запустить его с помощью Wine. Вы также можете попробовать PlayOnLinux, необычный интерфейс поверх Wine, который поможет вам установить популярные программы и игры для Windows.

Wine - это способ запустить программное обеспечение Windows в Linux, но без Windows. Wine - это уровень совместимости с Windows с открытым исходным кодом, который может запускать программы Windows непосредственно на любом рабочем столе Linux. По сути, Wine пытается заново реализовать Windows с нуля, чтобы можно было запускать все эти Windows-приложения, фактически не нуждаясь в Windows.

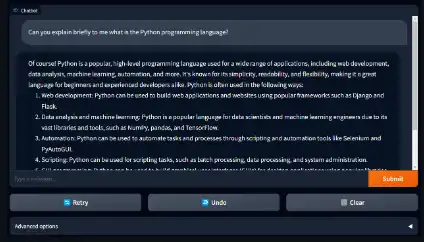

СКРИНШОТЫ

Ad

llama2-webui

ОПИСАНИЕ

Запуск Llama 2 с веб-интерфейсом Gradio на графическом процессоре или процессоре из любого места (Linux/Windows/Mac).

Особенности

- Поддержка всех моделей Llama 2 (7B, 13B, 70B, GPTQ, GGML) с 8-битным, 4-битным режимом.

- Используйте llama2-wrapper в качестве локального бэкэнда llama2 для генеративных агентов/приложений; пример сотрудничества

- Запустите API-интерфейс, совместимый с OpenAI, на моделях Llama2.

- Поддерживаемые модели: Llama-2-7b/13b/70b, все Llama-2-GPTQ, все Llama-2-GGML.

- Поддержка серверной части модели: трансформаторы, биты и байты (8-битный вывод), AutoGPTQ (4-битный вывод), llama.cpp.

- Демонстрации: запустите Llama2 на MacBook Air; Запустите Llama2 на бесплатном графическом процессоре Colab T4.

Язык программирования

Питон

Категории

Это приложение также можно загрузить с https://sourceforge.net/projects/llama2-webui.mirror/. Он размещен в OnWorks, чтобы его можно было проще запускать в Интернете из одной из наших бесплатных операционных систем.