นี่คือแอป Linux ชื่อ llm ซึ่งสามารถดาวน์โหลดรุ่นล่าสุดได้เป็น llm-cli-x86_64-pc-windows-msvc.zip สามารถทำงานออนไลน์ได้ใน OnWorks ผู้ให้บริการโฮสติ้งฟรีสำหรับเวิร์กสเตชัน

ดาวน์โหลดและเรียกใช้แอปออนไลน์ชื่อ llm พร้อม OnWorks ฟรี

ทำตามคำแนะนำเหล่านี้เพื่อเรียกใช้แอปนี้:

- 1. ดาวน์โหลดแอปพลิเคชั่นนี้ในพีซีของคุณ

- 2. เข้าไปที่ file manager https://www.onworks.net/myfiles.php?username=XXXXX ด้วยชื่อผู้ใช้ที่คุณต้องการ

- 3. อัปโหลดแอปพลิเคชันนี้ในตัวจัดการไฟล์ดังกล่าว

- 4. เริ่มโปรแกรมจำลองออนไลน์ของ OnWorks Linux หรือ Windows ออนไลน์ หรือโปรแกรมจำลองออนไลน์ MACOS จากเว็บไซต์นี้

- 5. จาก OnWorks Linux OS คุณเพิ่งเริ่มต้น ไปที่ตัวจัดการไฟล์ของเรา https://www.onworks.net/myfiles.php?username=XXXXX พร้อมชื่อผู้ใช้ที่คุณต้องการ

- 6. ดาวน์โหลดแอปพลิเคชั่น ติดตั้ง และเรียกใช้

ภาพหน้าจอ

Ad

llm

DESCRIPTION

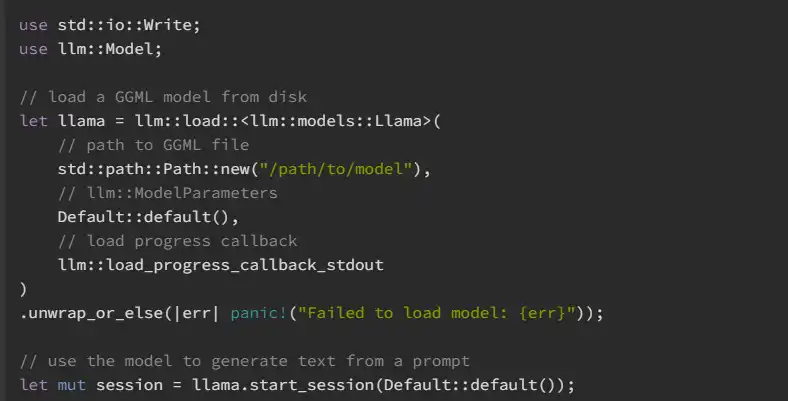

llm เป็นระบบนิเวศของไลบรารี Rust สำหรับการทำงานกับโมเดลภาษาขนาดใหญ่ ซึ่งสร้างขึ้นบนไลบรารี GGML ที่รวดเร็วและมีประสิทธิภาพสำหรับการเรียนรู้ของเครื่อง จุดเริ่มต้นหลักสำหรับนักพัฒนาคือลัง llm ซึ่งล้อมรอบฐาน llm และลังโมเดลที่รองรับ เอกสารประกอบสำหรับเวอร์ชันที่เผยแพร่มีอยู่ใน Docs.rs สำหรับผู้ใช้ปลายทาง มีแอปพลิเคชัน CLI llm-cli ซึ่งมีอินเทอร์เฟซที่สะดวกสำหรับการโต้ตอบกับรุ่นที่รองรับ การสร้างข้อความสามารถทำได้เพียงครั้งเดียวโดยอาศัยข้อความแจ้งหรือโต้ตอบผ่าน REPL หรือโหมดแชท CLI ยังสามารถใช้เพื่อทำให้โมเดลถอดรหัสเป็นอนุกรม (พิมพ์) หาปริมาณไฟล์ GGML หรือคำนวณความงุนงงของโมเดล สามารถดาวน์โหลดได้จาก GitHub รุ่นล่าสุดหรือโดยการติดตั้งจาก crates.io

คุณสมบัติ

- llm ขับเคลื่อนโดยไลบรารีเทนเซอร์ ggml และมีเป้าหมายที่จะนำความทนทานและความสะดวกในการใช้งานของ Rust มาสู่โลกของโมเดลภาษาขนาดใหญ่

- โปรเจ็กต์นี้ขึ้นอยู่กับ Rust v1.65.0 หรือสูงกว่าและ C toolchain ที่ทันสมัย

- ไลบรารี llm ได้รับการออกแบบมาเพื่อใช้ประโยชน์จากตัวเร่งฮาร์ดแวร์ เช่น cuda และ metal เพื่อประสิทธิภาพสูงสุด

- เพื่อให้ llm ควบคุมคันเร่งเหล่านี้ได้ จำเป็นต้องมีขั้นตอนการกำหนดค่าเบื้องต้นบางประการ

- วิธีที่ง่ายที่สุดในการเริ่มต้นใช้งาน llm-cli คือการดาวน์โหลดไฟล์ปฏิบัติการที่สร้างไว้ล่วงหน้าจาก llm เวอร์ชันที่วางจำหน่าย

- ตามค่าเริ่มต้น llm บิวด์ที่รองรับการดึงโทเค็นไนเซอร์จากฮับโมเดลของ Hugging Face จากระยะไกล

ภาษาโปรแกรม

สนิม

หมวดหมู่

นี่คือแอปพลิเคชันที่สามารถดึงข้อมูลจากhttps://sourceforge.net/projects/llm.mirror/ มีการโฮสต์ไว้ใน OnWorks เพื่อใช้งานออนไลน์ด้วยวิธีที่ง่ายที่สุดจากหนึ่งในระบบปฏิบัติการฟรีของเรา