นี่คือแอป Linux ชื่อ Web Crawler Security Tool ซึ่งสามารถดาวน์โหลดรีลีสล่าสุดเป็น crawler_v1.0.1.tar.gz สามารถเรียกใช้ออนไลน์ใน OnWorks ผู้ให้บริการโฮสต์ฟรีสำหรับเวิร์กสเตชัน

ดาวน์โหลดและเรียกใช้แอปนี้ทางออนไลน์ที่ชื่อว่า Web Crawler Security Tool พร้อม OnWorks ฟรี

ทำตามคำแนะนำเหล่านี้เพื่อเรียกใช้แอปนี้:

- 1. ดาวน์โหลดแอปพลิเคชั่นนี้ในพีซีของคุณ

- 2. เข้าไปที่ file manager https://www.onworks.net/myfiles.php?username=XXXXX ด้วยชื่อผู้ใช้ที่คุณต้องการ

- 3. อัปโหลดแอปพลิเคชันนี้ในตัวจัดการไฟล์ดังกล่าว

- 4. เริ่มโปรแกรมจำลองออนไลน์ของ OnWorks Linux หรือ Windows ออนไลน์ หรือโปรแกรมจำลองออนไลน์ MACOS จากเว็บไซต์นี้

- 5. จาก OnWorks Linux OS คุณเพิ่งเริ่มต้น ไปที่ตัวจัดการไฟล์ของเรา https://www.onworks.net/myfiles.php?username=XXXXX พร้อมชื่อผู้ใช้ที่คุณต้องการ

- 6. ดาวน์โหลดแอปพลิเคชั่น ติดตั้ง และเรียกใช้

ภาพหน้าจอ

Ad

เครื่องมือรักษาความปลอดภัยของโปรแกรมรวบรวมข้อมูลเว็บ

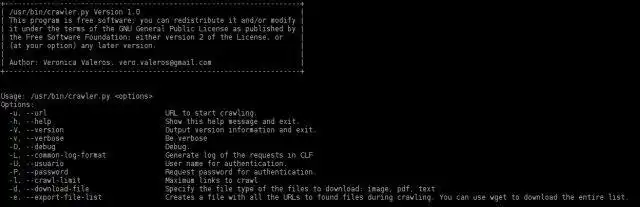

DESCRIPTION

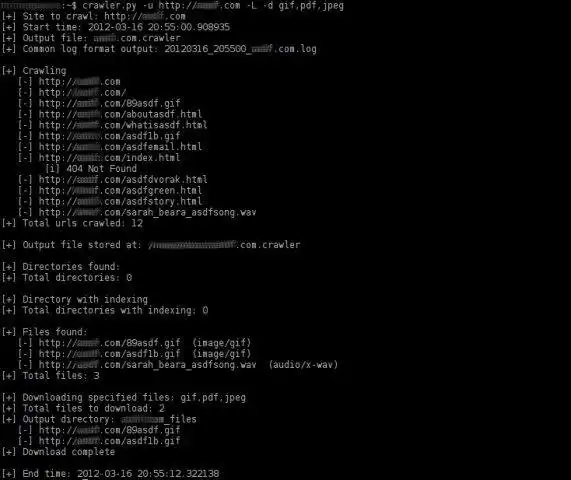

ปรับปรุงล่าสุดเมื่อ อ. 26 มี.ค. 16:25 UTC 2012Web Crawler Security เป็นเครื่องมือที่ใช้ python ในการรวบรวมข้อมูลเว็บไซต์โดยอัตโนมัติ เป็นโปรแกรมรวบรวมข้อมูลเว็บที่เน้นเพื่อช่วยในงานทดสอบการเจาะระบบ งานหลักของเครื่องมือนี้คือการค้นหาและแสดงรายการลิงก์ทั้งหมด (หน้าและไฟล์) ในเว็บไซต์

ตัวรวบรวมข้อมูลถูกเขียนใหม่อย่างสมบูรณ์ใน v1.0 โดยมีการปรับปรุงมากมาย: ปรับปรุงการแสดงภาพข้อมูล, ตัวเลือกแบบโต้ตอบเพื่อดาวน์โหลดไฟล์, เพิ่มความเร็วในการรวบรวมข้อมูล, ส่งออกรายการไฟล์ที่พบเป็นไฟล์แยก (มีประโยชน์ในการรวบรวมข้อมูลเว็บไซต์เพียงครั้งเดียว จากนั้น ดาวน์โหลดไฟล์และวิเคราะห์ด้วย FOCA) สร้างบันทึกเอาต์พุตใน Common Log Format (CLF) จัดการการรับรองความถูกต้องพื้นฐานและอีกมากมาย!

คุณลักษณะเก่าจำนวนมากได้ถูกนำกลับมาใช้ใหม่ และสิ่งที่น่าสนใจที่สุดคือความสามารถของโปรแกรมรวบรวมข้อมูลเพื่อค้นหาการจัดทำดัชนีไดเร็กทอรี

คุณสมบัติ

- รวบรวมข้อมูลเว็บไซต์ http และ https (แม้แต่เว็บไซต์ที่ไม่ได้ใช้พอร์ตทั่วไป) รวบรวมข้อมูลเว็บไซต์ http และ https (แม้แต่เว็บไซต์ที่ไม่ได้ใช้พอร์ตทั่วไป) รวบรวมข้อมูลเว็บไซต์ http และ https (แม้แต่เว็บไซต์ที่ไม่ได้ใช้พอร์ตทั่วไป)

- (ใหม่!) อนุญาตให้กำหนดความลึกของการรวบรวมข้อมูล (-C ตัวเลือก)

- (ใหม่!) สร้างสรุปเมื่อสิ้นสุดการรวบรวมข้อมูลพร้อมสถิติเกี่ยวกับผลการรวบรวมข้อมูล

- (ใหม่!) วิธีการ HEAD ที่นำมาใช้สำหรับการวิเคราะห์ประเภทไฟล์ก่อนการรวบรวมข้อมูล คุณลักษณะนี้ช่วยเพิ่มความเร็วของโปรแกรมรวบรวมข้อมูลอย่างมาก

- ใช้นิพจน์ทั่วไปเพื่อค้นหาลิงก์ 'href', 'src' และ 'content'

- ระบุลิงก์ที่เกี่ยวข้อง

- ระบุไฟล์ที่ไม่ใช่ html และแสดง

- ไม่รวบรวมข้อมูลไฟล์ที่ไม่ใช่ html

- ระบุการจัดทำดัชนีไดเร็กทอรี

- รวบรวมข้อมูลไดเรกทอรีที่มีการจัดทำดัชนี (ยังไม่ได้ใช้งานใน v1.0)

- ใช้ CTRL-C เพื่อหยุดขั้นตอนของโปรแกรมรวบรวมข้อมูลปัจจุบันและทำงานต่อไป สิ่งที่มีประโยชน์มาก...

- ระบุชนิดของไฟล์โดยการอ่านฟิลด์ส่วนหัวของประเภทเนื้อหาของการตอบกลับ

- ส่งออก (ตัวเลือก -e) ในไฟล์ที่แยกจากกัน รายการ URL ของไฟล์ทั้งหมดที่พบระหว่างการรวบรวมข้อมูล

- เลือกประเภทของไฟล์ที่จะดาวน์โหลด (ตัวเลือก -d) เช่น png,pdf,jpeg,gif หรือ png,jpeg

- เลือกแบบโต้ตอบว่าจะดาวน์โหลดไฟล์ประเภทใด (ตัวเลือก -i)

- บันทึกไฟล์ที่ดาวน์โหลดลงในไดเร็กทอรี มันสร้างไดเร็กทอรีเอาต์พุตก็ต่อเมื่อมีไฟล์ให้ดาวน์โหลดอย่างน้อยหนึ่งไฟล์

- สร้างบันทึกเอาต์พุตใน CLF (Common Log Format) ของคำขอทั้งหมดที่ทำระหว่างการรวบรวมข้อมูล

- (เบต้า) เข้าสู่ระบบด้วยการตรวจสอบสิทธิ์ขั้นพื้นฐาน ข้อเสนอแนะยินดีต้อนรับ!

- พยายามตรวจสอบว่าเว็บไซต์ใช้ CMS หรือไม่ (เช่น wordpress, joomla ฯลฯ) (ยังไม่ได้ใช้งานใน v1.0)

- ค้นหาไฟล์ '.bk' หรือ '.bak' ของหน้า php, asp, aspx, jps (ยังไม่ได้ใช้งานใน v1.0)

- ระบุและคำนวณจำนวนหน้าเว็บที่ไม่ซ้ำที่รวบรวมข้อมูล (ยังไม่ได้ใช้งานใน v1.0)

- ระบุและคำนวณจำนวนหน้าเว็บที่ไม่ซ้ำที่รวบรวมข้อมูลซึ่งมีพารามิเตอร์ใน URL (ยังไม่ได้ใช้งานใน v1.0)

- ใช้งานได้ใน Windows แต่ยังไม่ได้บันทึกผลลัพธ์

ผู้ชม

เทคโนโลยีสารสนเทศ

ส่วนติดต่อผู้ใช้

คอนโซล/เทอร์มินัล

ภาษาโปรแกรม

หลาม

นี่คือแอปพลิเคชันที่สามารถดึงข้อมูลจาก https://sourceforge.net/projects/webcrawler-py/ มีการโฮสต์ใน OnWorks เพื่อให้ทำงานออนไลน์ในวิธีที่ง่ายที่สุดจากหนึ่งในระบบปฏิบัติการฟรีของเรา