นี่คือแอป Windows ชื่อ Triton Inference Server ซึ่งสามารถดาวน์โหลดรีลีสล่าสุดเป็น Release2.38.0 ที่สอดคล้องกับNGCcontainer23.09.zip สามารถเรียกใช้ออนไลน์ใน OnWorks ผู้ให้บริการโฮสต์ฟรีสำหรับเวิร์กสเตชัน

ดาวน์โหลดและเรียกใช้แอปนี้ทางออนไลน์ที่ชื่อว่า Triton Inference Server พร้อม OnWorks ฟรี

ทำตามคำแนะนำเหล่านี้เพื่อเรียกใช้แอปนี้:

- 1. ดาวน์โหลดแอปพลิเคชั่นนี้ในพีซีของคุณ

- 2. เข้าไปที่ file manager https://www.onworks.net/myfiles.php?username=XXXXX ด้วยชื่อผู้ใช้ที่คุณต้องการ

- 3. อัปโหลดแอปพลิเคชันนี้ในตัวจัดการไฟล์ดังกล่าว

- 4. เริ่มโปรแกรมจำลองออนไลน์ของ OS OnWorks จากเว็บไซต์นี้ แต่โปรแกรมจำลองออนไลน์ของ Windows ที่ดีกว่า

- 5. จากระบบปฏิบัติการ Windows ของ OnWorks ที่คุณเพิ่งเริ่มต้น ไปที่ตัวจัดการไฟล์ของเรา https://www.onworks.net/myfiles.php?username=XXXXX พร้อมชื่อผู้ใช้ที่คุณต้องการ

- 6. ดาวน์โหลดแอปพลิเคชั่นและติดตั้ง

- 7. ดาวน์โหลดไวน์จากที่เก็บซอฟต์แวร์ลีนุกซ์ดิสทริบิวชันของคุณ เมื่อติดตั้งแล้ว คุณสามารถดับเบิลคลิกที่แอปเพื่อเรียกใช้แอปด้วย Wine คุณยังสามารถลองใช้ PlayOnLinux ซึ่งเป็นอินเทอร์เฟซแฟนซีบน Wine ที่จะช่วยคุณติดตั้งโปรแกรมและเกมยอดนิยมของ Windows

ไวน์เป็นวิธีเรียกใช้ซอฟต์แวร์ Windows บน Linux แต่ไม่จำเป็นต้องใช้ Windows Wine เป็นเลเยอร์ความเข้ากันได้ของ Windows แบบโอเพ่นซอร์สที่สามารถเรียกใช้โปรแกรม Windows ได้โดยตรงบนเดสก์ท็อป Linux โดยพื้นฐานแล้ว Wine พยายามนำ Windows กลับมาใช้ใหม่ให้เพียงพอตั้งแต่เริ่มต้น เพื่อให้สามารถเรียกใช้แอปพลิเคชัน Windows เหล่านั้นทั้งหมดโดยไม่จำเป็นต้องใช้ Windows จริงๆ

ภาพหน้าจอ

Ad

เซิร์ฟเวอร์การอนุมานไทรทัน

DESCRIPTION

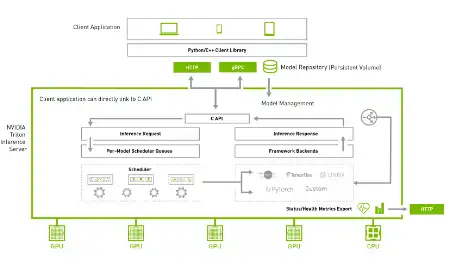

Triton Inference Server เป็นซอฟต์แวร์การอนุมานแบบโอเพนซอร์สที่ช่วยเพิ่มประสิทธิภาพการอนุมาน AI Triton ช่วยให้ทีมสามารถปรับใช้โมเดล AI จากเฟรมเวิร์กการเรียนรู้เชิงลึกและแมชชีนเลิร์นนิงที่หลากหลาย รวมถึง TensorRT, TensorFlow, PyTorch, ONNX, OpenVINO, Python, RAPIDS FIL และอื่นๆ Triton รองรับการอนุมานทั่วทั้งคลาวด์ ศูนย์ข้อมูล Edge และอุปกรณ์ฝังตัวบน NVIDIA GPU, x86 และ ARM CPU หรือ AWS Inferentia Triton มอบประสิทธิภาพที่ปรับให้เหมาะสมสำหรับคำถามประเภทต่างๆ รวมถึงเรียลไทม์ แบทช์ ตระการตา และการสตรีมเสียง/วิดีโอ จัดเตรียม Backend API ที่อนุญาตให้เพิ่มแบ็กเอนด์ที่กำหนดเองและการดำเนินการก่อน/หลังการประมวลผล จำลองไปป์ไลน์โดยใช้ Ensembling หรือ Business Logic Scripting (BLS) โปรโตคอลการอนุมาน HTTP/REST และ GRPC ตามโปรโตคอล KServe ที่พัฒนาโดยชุมชน AC API และ Java API ช่วยให้ Triton เชื่อมโยงโดยตรงกับแอปพลิเคชันของคุณสำหรับ edge และกรณีการใช้งานอื่นๆ ในกระบวนการ

คุณสมบัติ

- รองรับกรอบการเรียนรู้เชิงลึกที่หลากหลาย

- รองรับเฟรมเวิร์กการเรียนรู้ของเครื่องหลายตัว

- การดำเนินการแบบจำลองพร้อมกัน

- การแบ่งกลุ่มแบบไดนามิก

- ลำดับแบทช์และการจัดการสถานะโดยปริยายสำหรับโมเดลเก็บสถานะ

- จัดเตรียม Backend API ที่อนุญาตให้เพิ่มแบ็กเอนด์ที่กำหนดเองและการดำเนินการก่อน/หลังการประมวลผล

ภาษาโปรแกรม

หลาม

หมวดหมู่

นี่คือแอปพลิเคชันที่สามารถดึงข้อมูลจาก https://sourceforge.net/projects/triton-inference-server.mirror/ มีการโฮสต์ใน OnWorks เพื่อให้ทำงานออนไลน์ในวิธีที่ง่ายที่สุดจากหนึ่งในระบบปฏิบัติการฟรีของเรา