Đây là ứng dụng Windows có tên llm có bản phát hành mới nhất có thể được tải xuống dưới dạng llm-cli-x86_64-pc-windows-msvc.zip. Nó có thể được chạy trực tuyến trong nhà cung cấp dịch vụ lưu trữ miễn phí OnWorks dành cho máy trạm.

Tải xuống và chạy trực tuyến ứng dụng này có tên llm với OnWorks miễn phí.

Làm theo các hướng dẫn sau để chạy ứng dụng này:

- 1. Đã tải ứng dụng này xuống PC của bạn.

- 2. Nhập vào trình quản lý tệp của chúng tôi https://www.onworks.net/myfiles.php?username=XXXXX với tên người dùng mà bạn muốn.

- 3. Tải lên ứng dụng này trong trình quản lý tệp như vậy.

- 4. Khởi động bất kỳ trình giả lập trực tuyến OS OnWorks nào từ trang web này, nhưng trình giả lập trực tuyến Windows tốt hơn.

- 5. Từ Hệ điều hành Windows OnWorks bạn vừa khởi động, hãy truy cập trình quản lý tệp của chúng tôi https://www.onworks.net/myfiles.php?username=XXXXX với tên người dùng mà bạn muốn.

- 6. Tải xuống ứng dụng và cài đặt nó.

- 7. Tải xuống Wine từ kho phần mềm phân phối Linux của bạn. Sau khi cài đặt, bạn có thể nhấp đúp vào ứng dụng để chạy chúng với Wine. Bạn cũng có thể thử PlayOnLinux, một giao diện đẹp mắt trên Wine sẽ giúp bạn cài đặt các chương trình và trò chơi phổ biến của Windows.

Wine là một cách để chạy phần mềm Windows trên Linux, nhưng không cần Windows. Wine là một lớp tương thích Windows mã nguồn mở có thể chạy các chương trình Windows trực tiếp trên bất kỳ máy tính để bàn Linux nào. Về cơ bản, Wine đang cố gắng triển khai lại đủ Windows từ đầu để nó có thể chạy tất cả các ứng dụng Windows đó mà không thực sự cần đến Windows.

MÀN HÌNH

Ad

tôi

MÔ TẢ

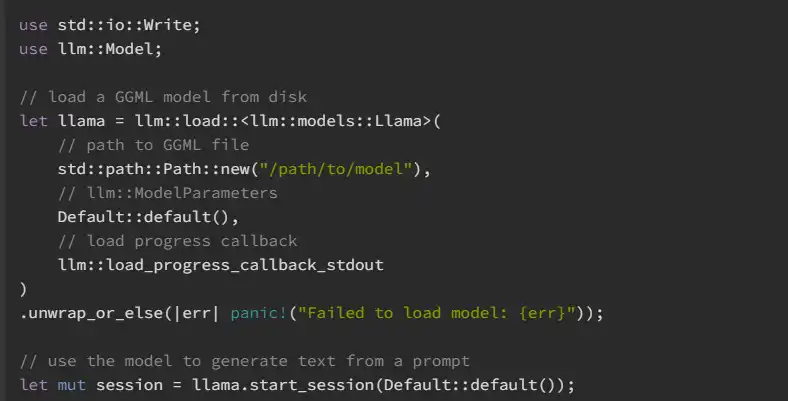

llm là một hệ sinh thái gồm các thư viện Rust để làm việc với các mô hình ngôn ngữ lớn - nó được xây dựng dựa trên thư viện GGML nhanh chóng, hiệu quả dành cho máy học. Điểm truy cập chính dành cho các nhà phát triển là thùng llm, bao bọc cơ sở llm và các thùng mô hình được hỗ trợ. Tài liệu cho phiên bản đã phát hành có sẵn trên Docs.rs. Đối với người dùng cuối, có một ứng dụng CLI, llm-cli, cung cấp giao diện thuận tiện để tương tác với các mô hình được hỗ trợ. Việc tạo văn bản có thể được thực hiện một lần dựa trên lời nhắc hoặc tương tác thông qua REPL hoặc chế độ trò chuyện. CLI cũng có thể được sử dụng để tuần tự hóa (in) các mô hình được giải mã, lượng tử hóa các tệp GGML hoặc tính toán độ phức tạp của mô hình. Nó có thể được tải xuống từ bản phát hành GitHub mới nhất hoặc bằng cách cài đặt nó từ Crate.io.

Tính năng

- llm được hỗ trợ bởi thư viện tensor ggml và nhằm mục đích mang lại sự mạnh mẽ và dễ sử dụng của Rust cho thế giới của các mô hình ngôn ngữ lớn

- Dự án này phụ thuộc vào Rust v1.65.0 trở lên và chuỗi công cụ C hiện đại

- Thư viện llm được thiết kế để tận dụng các bộ tăng tốc phần cứng như cuda và metal để tối ưu hóa hiệu suất

- Để cho phép llm khai thác các máy gia tốc này, cần có một số bước cấu hình sơ bộ

- Cách dễ nhất để bắt đầu với llm-cli là tải xuống tệp thực thi dựng sẵn từ phiên bản llm đã phát hành

- Theo mặc định, llm xây dựng với sự hỗ trợ tìm nạp mã thông báo từ xa từ trung tâm mô hình của Hugging Face

Ngôn ngữ lập trình

Rust

Danh Mục

Đây là một ứng dụng cũng có thể được tải xuống từ https://sourceforge.net/projects/llm.mirror/. Nó đã được lưu trữ trên OnWorks để có thể chạy trực tuyến một cách dễ dàng nhất từ một trong các Hệ điều hành miễn phí của chúng tôi.