Đây là ứng dụng Windows có tên TensorRT, bản phát hành mới nhất có thể được tải xuống dưới dạng TensorRTOSSv9.1.0sourcecode.zip. Nó có thể được chạy trực tuyến trong nhà cung cấp dịch vụ lưu trữ miễn phí OnWorks dành cho máy trạm.

Tải xuống và chạy trực tuyến ứng dụng có tên TensorRT này với OnWorks miễn phí.

Làm theo các hướng dẫn sau để chạy ứng dụng này:

- 1. Đã tải ứng dụng này xuống PC của bạn.

- 2. Nhập vào trình quản lý tệp của chúng tôi https://www.onworks.net/myfiles.php?username=XXXXX với tên người dùng mà bạn muốn.

- 3. Tải lên ứng dụng này trong trình quản lý tệp như vậy.

- 4. Khởi động bất kỳ trình giả lập trực tuyến OS OnWorks nào từ trang web này, nhưng trình giả lập trực tuyến Windows tốt hơn.

- 5. Từ Hệ điều hành Windows OnWorks bạn vừa khởi động, hãy truy cập trình quản lý tệp của chúng tôi https://www.onworks.net/myfiles.php?username=XXXXX với tên người dùng mà bạn muốn.

- 6. Tải xuống ứng dụng và cài đặt nó.

- 7. Tải xuống Wine từ kho phần mềm phân phối Linux của bạn. Sau khi cài đặt, bạn có thể nhấp đúp vào ứng dụng để chạy chúng với Wine. Bạn cũng có thể thử PlayOnLinux, một giao diện đẹp mắt trên Wine sẽ giúp bạn cài đặt các chương trình và trò chơi phổ biến của Windows.

Wine là một cách để chạy phần mềm Windows trên Linux, nhưng không cần Windows. Wine là một lớp tương thích Windows mã nguồn mở có thể chạy các chương trình Windows trực tiếp trên bất kỳ máy tính để bàn Linux nào. Về cơ bản, Wine đang cố gắng triển khai lại đủ Windows từ đầu để nó có thể chạy tất cả các ứng dụng Windows đó mà không thực sự cần đến Windows.

MÀN HÌNH

Ad

TenorRT

MÔ TẢ

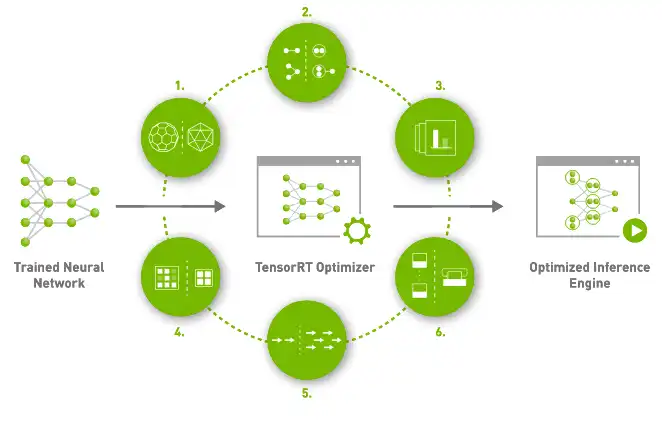

NVIDIA® TensorRT ™ là một SDK cho phép suy luận học sâu hiệu suất cao. Nó bao gồm một trình tối ưu hóa suy luận học sâu và thời gian chạy mang lại độ trễ thấp và thông lượng cao cho các ứng dụng suy luận học sâu. Các ứng dụng dựa trên TensorRT hoạt động nhanh hơn tới 40 lần so với các nền tảng chỉ dùng CPU trong quá trình suy luận. Với TensorRT, bạn có thể tối ưu hóa các mô hình mạng nơ-ron được đào tạo trong tất cả các khuôn khổ chính, hiệu chỉnh để có độ chính xác thấp hơn với độ chính xác cao và triển khai cho các trung tâm dữ liệu siêu tỷ lệ, nền tảng sản phẩm nhúng hoặc ô tô. TensorRT được xây dựng trên CUDA®, mô hình lập trình song song của NVIDIA và cho phép bạn tối ưu hóa các thư viện, công cụ phát triển và công nghệ tận dụng suy luận trong CUDA-X ™ cho trí tuệ nhân tạo, máy tự động, máy tính hiệu năng cao và đồ họa. Với GPU Kiến trúc NVIDIA Ampere mới, TensorRT cũng tận dụng các lõi tensor thưa thớt để tăng hiệu suất bổ sung.

Tính năng

- TensorRT cung cấp INT8 sử dụng Đào tạo Nhận thức Lượng tử hóa và Lượng tử hóa Sau Đào tạo

- Triển khai sản xuất các ứng dụng suy luận học sâu như phát trực tuyến video, nhận dạng giọng nói, đề xuất, v.v.

- Suy luận chính xác giảm xuống làm giảm đáng kể độ trễ của ứng dụng

- Với TensorRT, các nhà phát triển có thể tập trung vào việc tạo các ứng dụng mới do AI hỗ trợ thay vì điều chỉnh hiệu suất để triển khai suy luận

- Tối đa hóa thông lượng với FP16 hoặc INT8 bằng cách lượng hóa mô hình trong khi vẫn duy trì độ chính xác

- Tối ưu hóa việc sử dụng bộ nhớ GPU và băng thông bằng cách kết hợp các nút trong nhân

Ngôn ngữ lập trình

C + +

Danh Mục

Đây là một ứng dụng cũng có thể được tìm nạp từ https://sourceforge.net/projects/tensorrt.mirror/. Nó đã được lưu trữ trên OnWorks để có thể chạy trực tuyến một cách dễ dàng nhất từ một trong những Hệ thống hoạt động miễn phí của chúng tôi.