这是名为 TensorRT 的 Linux 应用程序,其最新版本可以下载为 23.08.zip。 它可以在工作站的免费托管服务提供商 OnWorks 中在线运行。

免费下载并在线运行这个名为 TensorRT with OnWorks 的应用程序。

请按照以下说明运行此应用程序:

- 1. 在您的 PC 中下载此应用程序。

- 2. 在我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX 中输入您想要的用户名。

- 3. 在这样的文件管理器中上传这个应用程序。

- 4. 从此网站启动OnWorks Linux online 或Windows online emulator 或MACOS online emulator。

- 5. 从您刚刚启动的 OnWorks Linux 操作系统,使用您想要的用户名转到我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX。

- 6. 下载应用程序,安装并运行。

SCREENSHOTS

Ad

张量RT

商品描述

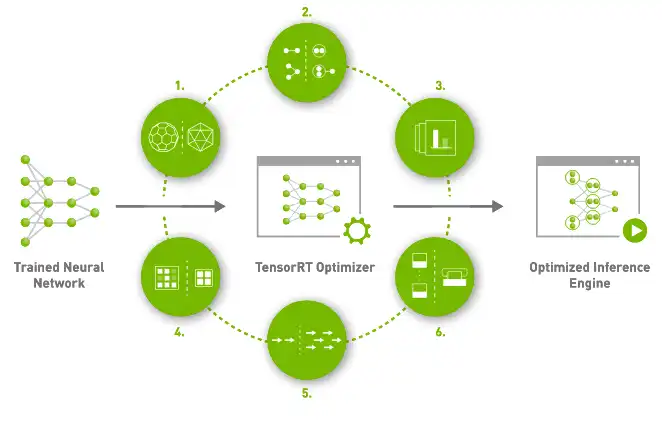

NVIDIA® TensorRT™ 是一款用于高性能深度学习推理的 SDK。 它包括一个深度学习推理优化器和运行时,可为深度学习推理应用程序提供低延迟和高吞吐量。 在推理过程中,基于 TensorRT 的应用程序的执行速度比纯 CPU 平台快 40 倍。 借助 TensorRT,您可以优化在所有主要框架中训练的神经网络模型,以高精度校准较低精度,并部署到超大规模数据中心、嵌入式或汽车产品平台。 TensorRT 基于 CUDA®(NVIDIA 的并行编程模型)构建,使您能够利用 CUDA-X™ 中的库、开发工具和技术优化推理,用于人工智能、自主机器、高性能计算和图形。 借助新的 NVIDIA Ampere 架构 GPU,TensorRT 还利用稀疏张量核心提供额外的性能提升。

产品优势

- TensorRT 使用 Quantization Aware Training 和 Post Training Quantization 提供 INT8

- 视频流、语音识别、推荐等深度学习推理应用的生产部署。

- 降低精度推理显着降低了应用程序延迟

- 使用 TensorRT,开发人员可以专注于创建新的 AI 驱动的应用程序,而不是为推理部署进行性能调整

- 通过量化模型在保持准确性的同时最大化 FP16 或 INT8 的吞吐量

- 通过融合内核中的节点来优化 GPU 内存和带宽的使用

程式语言

C + +中

分类

这是一个也可以从 https://sourceforge.net/projects/tensorrt.mirror/ 获取的应用程序。 它已托管在 OnWorks 中,以便通过我们的免费操作系统之一以最简单的方式在线运行。