这是名为 Xorbits Inference 的 Windows 应用程序,其最新版本可以作为 v0.5.4sourcecode.zip 下载。 它可以在免费的工作站托管提供商 OnWorks 中在线运行。

免费下载并在线运行名为 Xorbits Inference with OnWorks 的应用程序。

请按照以下说明运行此应用程序:

- 1. 在您的 PC 中下载此应用程序。

- 2. 在我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX 中输入您想要的用户名。

- 3. 在这样的文件管理器中上传这个应用程序。

- 4. 从本网站启动任何 OS OnWorks 在线模拟器,但更好的 Windows 在线模拟器。

- 5. 从您刚刚启动的 OnWorks Windows 操作系统,使用您想要的用户名转到我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX。

- 6. 下载应用程序并安装。

- 7. 从您的 Linux 发行版软件存储库下载 Wine。 安装后,您可以双击该应用程序以使用 Wine 运行它们。 您还可以尝试 PlayOnLinux,这是 Wine 上的一个花哨界面,可帮助您安装流行的 Windows 程序和游戏。

Wine 是一种在 Linux 上运行 Windows 软件的方法,但不需要 Windows。 Wine 是一个开源的 Windows 兼容层,可以直接在任何 Linux 桌面上运行 Windows 程序。 本质上,Wine 试图从头开始重新实现足够多的 Windows,以便它可以运行所有这些 Windows 应用程序,而实际上不需要 Windows。

SCREENSHOTS

Ad

X轨道推理

商品描述

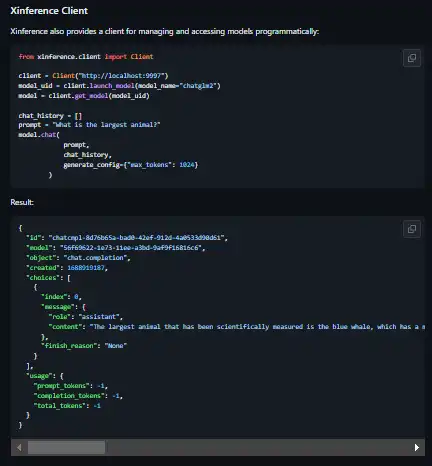

通过更改一行代码,将 OpenAI GPT 替换为应用程序中的另一个 LLM。 Xinference 让您可以自由地使用您需要的任何法学硕士。 借助 Xinference,您可以使用任何开源语言模型、语音识别模型和多模态模型运行推理,无论是在云端、本地还是在笔记本电脑上。 Xorbits Inference(Xinference)是一个强大且多功能的库,旨在服务于语言、语音识别和多模态模型。 借助 Xorbits Inference,您只需使用一个命令即可轻松部署和服务您的或最先进的内置模型。 无论您是研究人员、开发人员还是数据科学家,Xorbits Inference 都能帮助您释放尖端 AI 模型的全部潜力。

产品优势

- 简化服务大语言、语音识别和多模态模型的流程

- 您可以使用单个命令设置和部署模型以进行实验和生产

- 使用单个命令试验尖端的内置模型

- 使用 ggml 充分利用您的硬件资源

- 提供多种与模型交互的接口,支持 RPC、RESTful API(兼容 OpenAI API)、CLI 和 WebUI,实现无缝管理和监控

- 分布式部署场景中的 Excel,允许跨多个设备或机器无缝分布模型推理

程式语言

Python

分类

该应用程序也可以从 https://sourceforge.net/projects/xorbits-inference.mirror/ 获取。 它已托管在 OnWorks 中,以便从我们的免费操作系统之一以最简单的方式在线运行。