这是名为 Torch-TensorRT 的 Linux 应用程序,其最新版本可以下载为 Torch-TensorRTv1.3.0.zip。 它可以在工作站的免费托管服务提供商 OnWorks 中在线运行。

使用 OnWorks 免费下载并在线运行这个名为 Torch-TensorRT 的应用程序。

请按照以下说明运行此应用程序:

- 1. 在您的 PC 中下载此应用程序。

- 2. 在我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX 中输入您想要的用户名。

- 3. 在这样的文件管理器中上传这个应用程序。

- 4. 从此网站启动OnWorks Linux online 或Windows online emulator 或MACOS online emulator。

- 5. 从您刚刚启动的 OnWorks Linux 操作系统,使用您想要的用户名转到我们的文件管理器 https://www.onworks.net/myfiles.php?username=XXXXX。

- 6. 下载应用程序,安装并运行。

SCREENSHOTS

Ad

Torch-TensorRT

商品描述

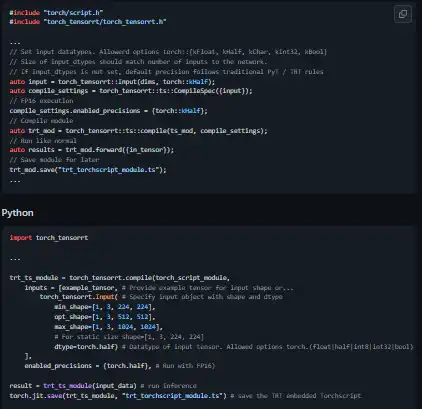

Torch-TensorRT 是 PyTorch/TorchScript 的编译器,通过 NVIDIA 的 TensorRT 深度学习优化器和运行时以 NVIDIA GPU 为目标。 与 PyTorch 的即时 (JIT) 编译器不同,Torch-TensorRT 是一种提前 (AOT) 编译器,这意味着在部署 TorchScript 代码之前,您需要通过显式编译步骤将标准 TorchScript 程序转换为一个针对 TensorRT 引擎的模块。 Torch-TensorRT 作为 PyTorch 扩展运行,并编译无缝集成到 JIT 运行时的模块。 编译后使用优化图应该感觉与运行 TorchScript 模块没有什么不同。 您还可以在编译时访问 TensorRT 的配置套件,因此您可以为您的模块指定操作精度 (FP32/FP16/INT8) 和其他设置。

产品优势

- 为 Torch-TensorRT 构建一个 docker 容器

- NVIDIA NGC 容器

- 需要 Libtorch 1.12.0(使用 CUDA 11.3 构建)

- 使用 cuDNN 和 TensorRT tarball 发行版构建

- 使用 Python 后端进行测试

- 你可以在编译时访问 TensorRT 的一套配置

程式语言

C + +中

分类

这个应用程序也可以从 https://sourceforge.net/projects/torch-tensorrt.mirror/ 获取。 它已托管在 OnWorks 中,以便以最简单的方式从我们的免费操作系统之一在线运行。