これは Xorbits Inference という名前の Linux アプリで、最新リリースは v0.5.3sourcecode.zip としてダウンロードできます。 ワークステーション用の無料ホスティング プロバイダー OnWorks でオンラインで実行できます。

Xorbits Inference with OnWorks という名前のこのアプリをオンラインで無料でダウンロードして実行します。

このアプリを実行するには、次の手順に従ってください。

-1。このアプリケーションをPCにダウンロードしました。

--2。ファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXに必要なユーザー名を入力します。

-3。このアプリケーションをそのようなファイルマネージャにアップロードします。

-4。このWebサイトからOnWorksLinuxオンラインまたはWindowsオンラインエミュレーターまたはMACOSオンラインエミュレーターを起動します。

-5。起動したばかりのOnWorksLinux OSから、必要なユーザー名でファイルマネージャーhttps://www.onworks.net/myfiles.php?username=XXXXXにアクセスします。

-6。アプリケーションをダウンロードし、インストールして実行します。

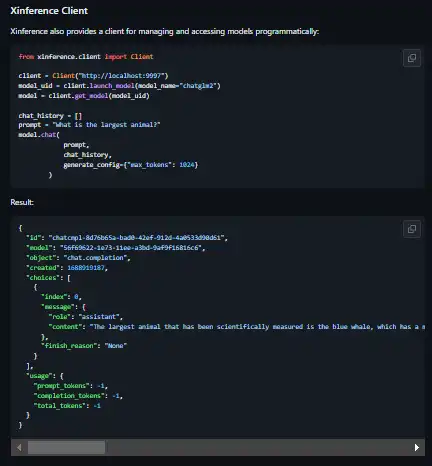

スクリーンショットは

Ad

Xorbits 推論

DESCRIPTION

コードを XNUMX 行変更することで、OpenAI GPT をアプリ内の別の LLM に置き換えます。 Xinference を使用すると、必要な LLM を自由に使用できます。 Xinference を使用すると、クラウド、オンプレミス、またはラップトップ上であっても、オープンソースの言語モデル、音声認識モデル、マルチモーダル モデルを使用して推論を実行できます。 Xorbits Inference (Xinference) は、言語、音声認識、およびマルチモーダル モデルを提供するように設計された強力で多用途のライブラリです。 Xorbits Inference を使用すると、単一のコマンドを使用するだけで、独自のモデルまたは最先端の組み込みモデルを簡単にデプロイして提供できます。 研究者、開発者、データ サイエンティストのいずれであっても、Xorbits Inference を使用すると、最先端の AI モデルの可能性を最大限に引き出すことができます。

特徴

- 大規模な言語、音声認識、およびマルチモーダル モデルを提供するプロセスを簡素化します。

- 単一のコマンドで実験と実稼働用にモデルをセットアップしてデプロイできます。

- 単一のコマンドを使用して最先端の組み込みモデルを実験します

- ggml でハードウェア リソースを最大限に活用する

- モデルと対話するための複数のインターフェイスを提供し、RPC、RESTful API (OpenAI API と互換性あり)、CLI、WebUI をサポートしてシームレスな管理と監視を実現します

- 分散展開シナリオにおける Excel により、複数のデバイスまたはマシン間でのモデル推論のシームレスな分散が可能になります。

プログラミング言語

Python

カテゴリー

これは、https://sourceforge.net/projects/xorbits-inference.mirror/ から取得できるアプリケーションです。 無料のオペレーティング システムの XNUMX つから最も簡単な方法でオンラインで実行できるように、OnWorks でホストされています。