Ini ialah apl Windows bernama Triton Inference Server yang keluaran terbarunya boleh dimuat turun sebagai Release2.38.0correspondingtoNGCcontainer23.09.zip. Ia boleh dijalankan dalam talian dalam penyedia pengehosan percuma OnWorks untuk stesen kerja.

Muat turun dan jalankan dalam talian aplikasi bernama Triton Inference Server ini dengan OnWorks secara percuma.

Ikut arahan ini untuk menjalankan apl ini:

- 1. Memuat turun aplikasi ini dalam PC anda.

- 2. Masukkan dalam pengurus fail kami https://www.onworks.net/myfiles.php?username=XXXXX dengan nama pengguna yang anda mahukan.

- 3. Muat naik aplikasi ini dalam pengurus filem tersebut.

- 4. Mulakan mana-mana emulator dalam talian OS OnWorks daripada tapak web ini, tetapi emulator dalam talian Windows yang lebih baik.

- 5. Daripada OS Windows OnWorks yang baru anda mulakan, pergi ke pengurus fail kami https://www.onworks.net/myfiles.php?username=XXXX dengan nama pengguna yang anda mahukan.

- 6. Muat turun aplikasi dan pasangnya.

- 7. Muat turun Wine dari repositori perisian pengedaran Linux anda. Setelah dipasang, anda kemudian boleh mengklik dua kali aplikasi untuk menjalankannya dengan Wine. Anda juga boleh mencuba PlayOnLinux, antara muka mewah melalui Wine yang akan membantu anda memasang program dan permainan Windows yang popular.

Wain ialah cara untuk menjalankan perisian Windows pada Linux, tetapi tanpa Windows diperlukan. Wain ialah lapisan keserasian Windows sumber terbuka yang boleh menjalankan program Windows secara langsung pada mana-mana desktop Linux. Pada asasnya, Wine cuba untuk melaksanakan semula Windows yang mencukupi dari awal supaya ia boleh menjalankan semua aplikasi Windows tersebut tanpa memerlukan Windows.

SKRIN

Ad

Pelayan Inferens Triton

DESCRIPTION

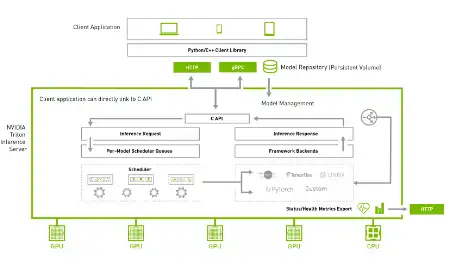

Triton Inference Server ialah perisian penyajian inferens sumber terbuka yang menyelaraskan inferens AI. Triton membolehkan pasukan menggunakan mana-mana model AI daripada pelbagai pembelajaran mendalam dan rangka kerja pembelajaran mesin, termasuk TensorRT, TensorFlow, PyTorch, ONNX, OpenVINO, Python, RAPIDS FIL dan banyak lagi. Triton menyokong inferens merentas awan, pusat data, edge dan peranti terbenam pada GPU NVIDIA, x86 dan CPU ARM atau AWS Inferentia. Triton menyampaikan prestasi yang dioptimumkan untuk banyak jenis pertanyaan, termasuk masa nyata, berkumpulan, ensembel dan penstriman audio/video. Menyediakan API Bahagian Belakang yang membenarkan penambahan bahagian belakang tersuai dan operasi pra/pasca pemprosesan. Model saluran paip menggunakan Ensembling atau Business Logic Scripting (BLS). Protokol inferens HTTP/REST dan GRPC berdasarkan protokol KServe yang dibangunkan komuniti. AC API dan Java API membenarkan Triton memaut terus ke aplikasi anda untuk edge dan kes penggunaan dalam proses yang lain.

Ciri-ciri

- Menyokong pelbagai rangka kerja pembelajaran mendalam

- Menyokong pelbagai rangka kerja pembelajaran mesin

- Pelaksanaan model serentak

- Pengumpulan dinamik

- Pengumpulan jujukan dan pengurusan keadaan tersirat untuk model stateful

- Menyediakan API Bahagian Belakang yang membenarkan penambahan bahagian belakang tersuai dan operasi pemprosesan pra/pasca

Bahasa Pengaturcaraan

Python

Kategori

Ini adalah aplikasi yang juga boleh diambil dari https://sourceforge.net/projects/triton-inference-server.mirror/. Ia telah dihoskan dalam OnWorks untuk dijalankan dalam talian dengan cara yang paling mudah daripada salah satu Sistem Operasi percuma kami.